Die Herkunft eines Menschen – ob Land, Ort oder sogar nur Stadtteil – beeinflusst maßgeblich seine Sicht auf die Welt. In vielen Ländern beschäftigen sich Ethikräte mit unterschiedlichsten Fragestellungen, seien sie rechtlich, naturwissenschaftlich, religiös oder medizinisch.

Gibt es auf einem Themengebiet neue Möglichkeiten, Erfindungen oder Durchbrüche, so ist es die Aufgabe des Ethikrates zu klären, ob und in welcher Form eine Nutzung dieser Dinge ethisch korrekt und überhaupt möglich ist. In der Medizin zum Beispiel ist das bei Studien zwingend vorgeschrieben.

Mit der Entwicklung der KI (künstlichen Intelligenz) ist ein solcher Fall eingetreten. Im Jahre 2004 fand in Sanremo (Italien) das erste internationale Symposion zur Roboterethik statt. Zu klären sind in diesem Zusammenhang etliche Fragen. Wo genau endet z.B. die programmierte KI und wo beginnt ein Bewusstsein? Sollten Roboter eigene Rechte erhalten? Je nachdem, wie weit die Entwicklung voranschreitet, sollte man hier aus unterschiedlichen Perspektiven herangehen.

Wie weit darf Technik gehen?

Doch auch die Frage, wie weit die rein programmierte Technik gehen darf und wie Entscheidungen zu fällen sind, muss unbedingt geklärt werden. Im Film „I, Robot“ hat es Will Smith mit einem fühlenden Roboter zu tun. Dieser wurde darauf programmiert, die drei Asimov‘schen Robotergesetze einzuhalten:

- Ein Roboter darf kein menschliches Wesen (wissentlich) verletzen oder durch Untätigkeit (wissentlich) zulassen, dass einem menschlichen Wesen Schaden zugefügt wird.

- Ein Roboter muss den ihm von einem Menschen gegebenen Befehlen gehorchen – es sei denn, ein solcher Befehl würde mit der ersten Regel kollidieren.

- Ein Roboter muss seine Existenz beschützen, solange dieser Schutz nicht mit der ersten oder zweiten Regel kollidiert.

Diese Gesetze wurden vom Schriftsteller Isaac Asimov in seiner Kurzgeschichte Runaround zum ersten Mal erwähnt.

Im Film ist nun angeblich ein Wissenschaftler in den Freitod gesprungen, einziger Zeuge: Sonny, ein Roboter mit künstlicher Intelligenz.

Anders als die anderen Roboter verfügt Sonny über einen freien Willen und wird nicht vom Hauptcomputer V.I.K.I. gesteuert. V.I.K.I. hat die Menschen analysiert und für sich entschieden, dass die Menschen und ihre Handlungsweisen den Mitmenschen und der Erde schaden.

Spielfilm „I am Robot“

Sie beschließt daher, die Roboter zu nutzen, um die Menschen zu lenken. Am Ende stellt sich heraus: Der Wissenschaftler hatte Sonny gebeten, ihn durch ein Fenster zu stoßen, um so die Polizei zu verständigen. Er kannte Detective Spooner (von Will Smith gespielt), den ermittelnden Polizisten, und sein Misstrauen Computern gegenüber.

Denn Spooner wurde einmal von einem Roboter aus einem im Wasser versinkenden Auto gerettet, während das Mädchen ertrank. Und dies einfach, weil die Überlebenschancen für ihn höher waren als die für das Mädchen.

Was hier tatsächlich reine Science Fiction ist, ist heute jedoch bereits Realität. Denn auch wenn es diese typischen, menschenähnlichen Roboter noch nicht gibt, so sind bereits Vorläufer vorhanden, zum Beispiel in selbstfahrenden Autos.

Selbstfahrende Autos treffen Entscheidungen

Und auch hier stellt sich eine ethische Grundfrage: Was passiert, wenn ein solches Fahrzeug im Notfall selbst entscheiden muss? Sollten in jedem Fall die Insassen geschützt werden? Oder lieber Außenstehende? Fragt man hier Menschen unterschiedlicher Herkunft, so wird es hunderte unterschiedlicher Antworten geben.

Dass es sich genau so verhält, hat das MIT (Massachusetts Institute of Technology) herausgefunden, das sich mit genau dieser Frage beschäftigt hat.

Angenommen, ein Auto ist gezwungen, einem Hindernis auszuweichen: Welche Richtung soll es einschlagen, welche Opfer eher in Kauf nehmen?

Hier werden die unmöglichsten Fragen erörtert, um herauszufinden, wie ein Mensch sich entscheiden würde. Doch seien wir einmal ehrlich: In einer solchen Situation denkt ein Mensch doch nicht nach. Ein Mensch reagiert.

Mysticsartdesign / Pixabay

Und hier ganz sicher auch aufgrund eigener Erfahrungen sowie unter Gesichtspunkten der eigenen Erziehung und des eigenen Pflichtgefühls. Menschen würden sicherlich häufig die falsche Entscheidung treffen, wenn es wirklich darauf ankommt. Teilweise sicherlich auch, weil die Chancen und Wahrscheinlichkeiten falsch eingeschätzt würden.

Ist hier also ein Computer möglixherweise der menschlichen Ethik und Moral überlegen? Sollte die Vorgehensweise rein rechnerisch festgelegt werden? Während im englischen Sprachraum die Ansicht vorherrscht, dass immer die Lösung bevorzugt werden sollte, die mehr Leben rettet, ist es in Deutschland beispielsweise verboten, Leben gegeneinander aufzuwiegen. J

edes Leben ist gleich viel wert. So dürfte ein Flugzeug, das in ein Hochhaus fliegt, nicht abgeschossen werden, um damit viele Leben zu retten, denn die wenigen Leben in der Maschine wären genauso viel wert.

Wo also sollten Computer eingreifen dürfen und wo nicht? Sicherlich muss irgendwann eine Entscheidung getroffen werden, die Frage ist nur, ob diese Entscheidung einzig bei den Programmierern liegen sollte oder ob nicht die Gesellschaft als solche diese schwere Entscheidung zu treffen hat.

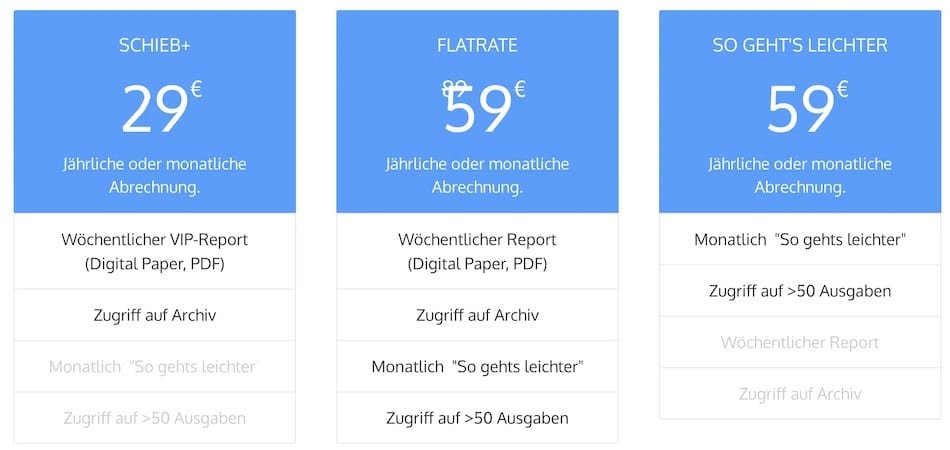

Mehr dazu lesen Sie aus der Quelle