Go ist ein äußerst komplexes Spiel, das den Spielern alles abverlangt. Jetzt ist es einem Forscherteam von Google gelungen, eine Software zu schreiben, die besser Go spielt als der amtierende Weltmeister. Ein Durchbruch für die Künstliche Intelligenz.

Das Brettspiel GO ist in Asien besonders beliebt. Hier setzen zwei Spieler abwechselnd flache, runde Steine auf das Spielfeld – und müssen versuchen, dabei geometrische Figuren zu erzeugen. Wenn diese Figuren geschlossen sind, darf der eine Spieler alle Steine des anderen Spielers vom Feld nehmen. Google und Facebook entwickeln hoch anspruchsvolle Systeme, die Go spielen. Sie wollen so Erkenntnisse über Künstliche Intelligenz gewinnen. Jetzt hat ein System von Google zum ersten Mal einen Go-Profi geschlagen.

Was verstehst man eigentlich unter „Künstlicher Intelligenz“?

Darunter versteht man gemeinhin Software, die Entscheidungsprozesse eines Menschen nachahmt und selbständig dazu lernt und Situationen analysiert. Das ist eine unglaublich schwierige Herausforderung, weil man die Denkweise und die Art des Verstehens und Entscheidend von Menschen nachbilden muss. In Spielen funktioniert das mittlerweile ganz gut.

Was ist bei Go anders als zum Beispiel bei Schach?

Go ist viel, viel komplexer als Schach. Ein Schachfeld hat 8×8 Felder, ein Go-Spielfeld hat 19×19 Felder – und es sind deutlich mehr Steine auf dem Brett. Es gibt viel mehr mögliche Spielsituationen, die trainiert oder bewertet werden müssen. Entsprechend ist es für ein Computersystem schwieriger, die Folgen zu berechnen. Go gilt deshalb als Königsdisziplin der KI-Forschung. Eine Go-Software ist um ein Vielfaches anspruchsvoller als ein Schach-Programm.

Wie bringt man denn einem Computer (einer KI) das Spielen bei?

Da gibt es unterschiedliche Ansätze. Bei simplen Spielen wie Tic-Tac-Toe reichen einfache Algorithmen. Bei Actionspiele wie „Pong“ oder allem, was sich auf dem Bildschirm bewegt, ist auch nicht sonderlich viel Software nötig. Schwierig wird es bei Spielen, die sehr komplex sind. Hier werden „neuronale Netzwerke“ programmiert. Die werden so genannt, weil sie lernfähig sind.

Die Programme probieren immer wieder Dinge aus – und lernen durch Scheitern oder Erfolg dazu. Im Grunde wie Menschen, nur stoischer und schneller. Die Netzwerke spielen gegen sich selbst und lernen so immer besser, die Folgen eines Zugs zu beurteilen. Etwa bei Schach oder eben Go. Die Software lernt, aktuelle Spielstände zu bewerten: Welches Gewicht hat jeder einzelne Stein auf dem Spielfeld?

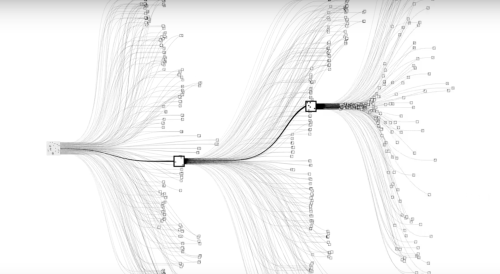

Anschließend müssen die möglichen Folgen, die Chancen und Risiken jedes einzelnen möglichen Zugs beurteilt werden – und das alles natürlich möglichst schnell. Im Hintergrund gibt es ein „Wert-Netzwerk“, das die jeweilige Konstellation auf dem Brett beurteilt und ein „Policy-Netzwerk“, das passende Züge auswählt. Kombiniert wurden diese beiden Netze mit einer klassischen Entscheidungs-Baum-Methode namens Monte Carlo Tree Search.

Was muss man sich denn künftig unter KI vorstellen? Superschlaue Assistenten, die auf alles eine Antwort haben?

Im Grunde schon – das ist durchaus das Ziel der KI-Forscher. Digitale Assistenten wie wir sie heute in Smartphones haben – also Siri, Cortana, Google Now – sind erste Vorboten.

Sie können simpelste Fragen schon „verstehen“ und beantworten, auch einfache Arbeitsanweisungen ausführen wie „Trage einen Termin ein für 14.00 Uhr: Zahnarzt – und erinnere mich eine Stunde vorher“. Doch bis sie wirklich intelligent agieren, wird noch viel Zeit vergehen.

Die Software von Deepmind, die jetzt in Go so gut spielt, braucht ein Rechnernetzwerk mit 1000 Prozessoren und nahezu 200 Grafikkarten, die parallel rechnen. Nur um Go zu spielen. Wenn ein System mit künstlicher Intelligenz noch mehr können soll, ist entsprechend mehr Rechenleistung erforderlich.

Ist das jetzt ein Durchbruch, was Google da bei Go gelungen ist?

Das kann man wohl sagen. Die Experten hatten erwartet, dass es noch 10 Jahre dauern wird, bis man den besten Spieler in Go wird schlagen können. Jetzt ist es bereits so weit. Das bedeutet: Die Forscher haben eindeutig Fortschritte gemacht, können bessere neuroyale Netze programmieren – und bekommen größere Rechenleistungen zur Verfügung gestellt.