FLOWER und BEAST: Europäische KI macht Roboter menschenähnlich

Europäische KI-Modelle FLOWER und BEAST machen Roboter endlich menschenähnlich – trainierbar auf normaler Hardware für intuitive Haushalts- und Pflegeroboter.

Europäische KI-Modelle FLOWER und BEAST machen Roboter endlich menschenähnlich – trainierbar auf normaler Hardware für intuitive Haushalts- und Pflegeroboter.

Microsoft 365 Copilot analysiert jetzt E-Mails und Teams-Chats automatisch. Diese neuen KI-Features können euren Büroalltag spürbar erleichtern.

KI-Agenten – also Programme, die eigenständig Aufgaben erledigen statt nur Fragen zu beantworten – gibt es schon länger. Doch was in den letzten Tagen passiert ist, hat eine völlig neue Qualität: OpenAI, Meta und Anthropic haben praktisch gleichzeitig Milliarden in diese Technologie gesteckt. Was steckt dahinter, was können die neuen Agenten – und was bedeutet das für euch?

Meta testet KI-Tool für personalisierte Instagram-Profilbilder. Coole Sache oder Datenschutz-Alptraum? Wir schauen genau hin.

Netflix testet KI-Empfehlungen mit Stimmungsanalyse. Ab 2026 soll die neue Technologie eure Filmauswahl revolutionieren und endloses Scrollen beenden.

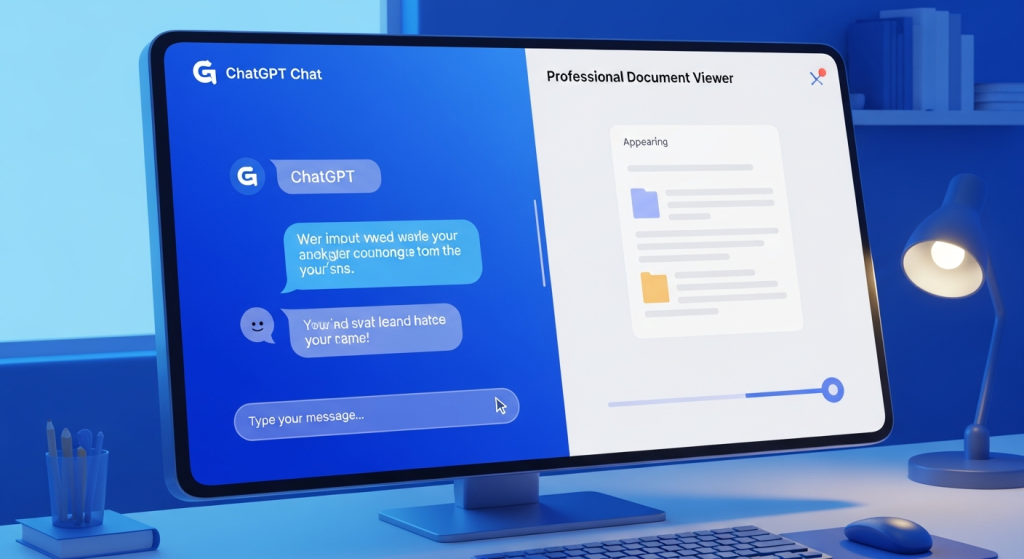

OpenAI macht ChatGPT Deep Research professioneller: Ein neuer Full-Screen-Viewer zeigt Analyseberichte übersichtlich wie echte Dokumente an.

OpenAI hat ChatGPT Voice verbessert – mit besserem Sprachverständnis und Web-Suche. Wir haben getestet, was das Update wirklich bringt.

OpenAI verbessert ChatGPT Voice deutlich: Präzisere Spracherkennung, Web-Suche per Sprachbefehl und bessere Tool-Integration machen Voice zur vollwertigen Alternative.