Derzeit kursieren Fotos, die den Papst in einer hippen weißen Daunenjacke zeigen. Oder Donald Trump, wie er vor der Polizei flüchtet. Wie solche mit KI erzeugte Fake-Fotos entstehen – und warum sie gefährlich sind (und immer gefährlicher für uns werden).

Der Papst, unterwegs in einer stylischen weißen Daunenjacke und mit unverwechselbarem päpstlichem Kruzifix bestückt: Dieses Foto – es gibt sogar gleich mehrere davon – geht gerade viral im Netz. Die Aufnahme sorgt für Lacher und provoziert hämische Kommentare, da das geistliche Oberhaupt der Katholischen Kirche wie ein Rapper daherkommt. Oder zumindest doch wie ein hipper Influencer.

KI-Systeme wie Midjourney erstellen Deepfakes

Aber: Das Foto ist nachweislich Fake, eine Fälschung. Entstanden mit Hilfe von Künstlicher Intelligenz (KI). Das KI-System „Midjourney“, das darauf spezialisiert ist, auf Anweisung durch einen Benutzer („Prompt“ genannt) praktisch jedes beliebige Foto oder Bild zu erzeugen – und sei es auch noch so abenteuerlich –, hat die viral gehenden Aufnahmen mit nur wenige Sekunden Rechenaufwand generiert.

Keineswegs einfach so und von allein, sondern weil jemand der KI den Befehl gegeben hat. Etwa in der Art: „Erzeuge ein fotorealistisches Bild, das den aktuellen Papst in weißer Daunenjacke zeigt“. Midjourney ist ein „Text-to-Image“-System. Es erzeugt aufgrund von Anweisungen Bilder.

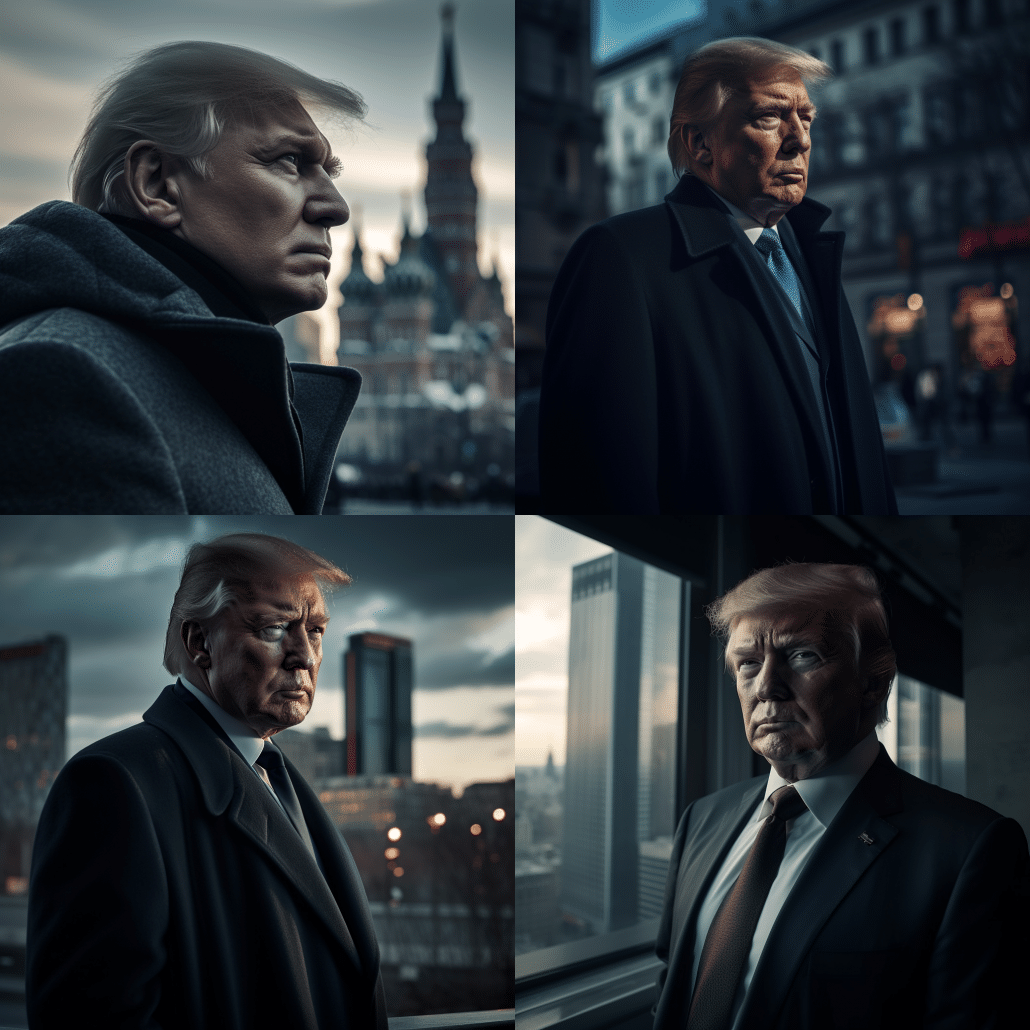

Von einem Künstler erstellte Deepfakes: Donald Trump wird verhaftet

Etwas komplexer sind die nötigen Anweisungen schon, um Aufnahmen dieser Qualität zu erzeugen. Aber die Ergebnisse, die Midjourney und andere vergleichbare auf Bilderstellung spezialisierte KI-Systeme heute innerhalb von Sekunden erstellen, sind – technisch betrachtet – durchaus beeindruckend. Gerade erst ist die neue Version 5 von Midjourney an den Start gegangen, die spezialisiert ist auf fotorealistische Aufnahmen – und KI-Fotos in nie dagewesener Qualität bietet. Wie eben das vom Papst in weißer Daunenjacke.

Solche Aufnahmen, die komplett von KI erzeugt werden und niemals fotografiert wurden, werden „Deepfakes“ genannt: Weil sie durch „Deep Learning“ entstehen, eine Form von Künstlicher Intelligenz – und weil sie eben „Fake“ sind, eine Fälschung.

Deepfake: Putin kniet vor Xi Jinping

Weiterer Deepfake: Festnahme von Donald Trump

Derzeit kursieren zahlreiche weitere Deepfakes, die Verwirrung stiften. Etwa ein Donald Trump, der vor diversen Polizeibeamten flüchtet – und dann doch gefasst wird. In einer anderen Aufnahme widersetzt sich der Ex-Präsident mit aller Kraft der Verhaftung. Aber eine, die es aber nie gegeben hat.

Genau darin liegt die Brisanz solcher Deepfakes: Sie sehen auf den ersten Blick täuschend echt aus, haben aber das Potenzial, die Gemüter zu erhitzen. Es muss nur jemand behaupten, es wäre passiert. Eine durch Polizisten verhafteten Trump ebenso wie ein Wladimir Putin, der vor dem chinesischen Regierungschef Xi Jinping auf die Knie fällt und ihm die Hand küsst – ein weiterer Deepfake, der im Netz kursiert.

Deepfakes enthalten zweifellos Sprengstoff – und je besser die Bildqualität, desto höher die Sprengkraft. Sie könnten den Eindruck erwecken, prominente Personen wären irgendwo gewesen, hätten bestimmte Personen getroffen, etwa getan – oder gesagt. Denn Deepfakes sind längst nicht mehr nur auf Fotos beschränkt. Vergleichbare KI-Systeme wie „Dreamix“ von Google erzeugen auf ähnliche Art und Weise und ebenso mühelos auch Videos. Es reicht, ein Foto hochzuladen und den Befehl zu geben: „Lass diese Person eine verbotene Substanz konsumieren“. Fertig ist der Skandal.

Donald Trump in Moscow: Fotos sind in KI entstanden

Deepfake Video – mit Fake-Stimme

Andere KI-Systeme sind in der Lage, mit der Stimme jedes Menschen zu sprechen. Es reichen wenige Sekunden Audiomaterial, und die KI analysiert den Sprechstil und kann dann jeden beliebigen Text „sprechen“. Werden diese Technologien kombiniert, entstehen nicht nur Deepfake-Fotos, sondern auch Videos, die alles Mögliche zeigen können. Auf diese Weise wurde zum Beispiel Berlins damals regierenden Bürgermeistern Franziska Giffey ein Fake-Klitchko untergejubelt.

Einzelne Deepfakes können unterhaltsam sein, doch durch die immer bessere Bild- und Tonqualität sind sie vor allem gefährlich. Politische Gruppierungen oder Regierungen könnten solche Deepfakes einsetzen, um Personen, Parteien, Gruppierungen oder Institutionen zu diskreditieren. Das gelingt durch das enorme Tempo in Social Media heute schnell. Das kann zu politischen Verwerfungen führen – oder zu unruhigen Börsen.

Deepfakes immer schwieriger zu enttarnen

Noch gibt es Auffälligkeiten in solchen Deepfakes, etwa merkwürdig unnatürlich aussehende Hände – oder „Artefakte“ genannte Störungen im Bild. Aber die Künstliche Intelligenz entwickelt sich derzeit rasant. Es ist nur eine Frage der Zeit, bis Deepfakes mit natürlichem Auge nicht mehr von echten Aufnahmen zu unterscheiden sind. Zwar gibt es bereits Werkzeuge, die solche Aufnahmen untersuchen und eine Einschätzung vornehmen, wie wahrscheinlich es ist, dass sie mit Hilfe von KI erzeugt wurde. Aber Verwirrung erzeugen können solche Aufnahmen dann dennoch.