Eigentlich sollten Social Networks der freundlichen Kontaktanbahnung, dem Gedankenaustausch und dem Networking Dienen. Eigentlich. Doch dann kam es ganz anders. Jeder vierte Deutsche wurde mittlerweile auf den Plattformen bedroht oder beleidigt. Was tun?

Soziale Netzwerke wie Facebook, Instagram, Twitter/X und Tiktok: Einst Orte für Spaß-Videos, How-To-Anleitungen oder Selbstpräsentation, ja auch Austausch. Seit Jahren aber auch Orte mit jeder Menger versteckter oder direkter Werbung. Stichwort Influencer.

Doch inzwischen gibt es keine Plattform mehr, auf der nicht Hass, Hetze und Propaganda zunehmen. Das erleben nicht nur wir Nutzer, sondern das zeigen auch Studien. Da macht es oft keinen Spaß mehr, Postings auf Facebook oder Twitter alias X zu lesen. Wer kann oder müsste das ändern? Die Konzerne, die Politik – und wer macht die ganze Arbeit? – Oder müssen wir Nutzer selbst ran?

Studien belegen: Ton wird immer rauher

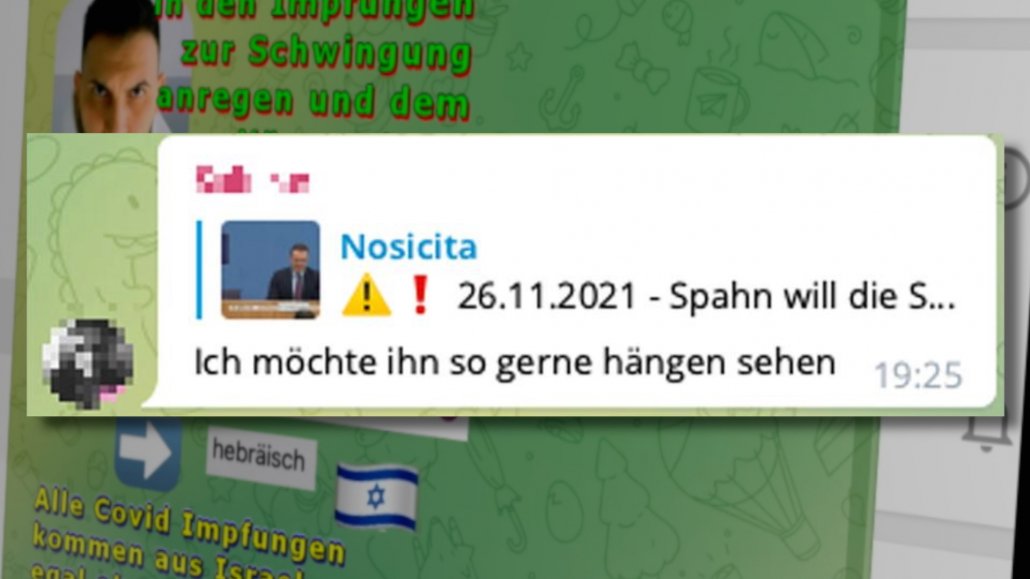

Wir merken es doch irgendwie alle: In den angeblich „sozialen Netzwerken“ herrscht ein immer rauerer Ton. Oft genug kippt es um in Hass und Hetze. Ist das nur ein subjektiver Eindruck – dazu gibt es sogar diverse Studien (Unten sind einige verlinkt).

Man kann mit Fug und Recht sagen, dass dieser Bereich in den letzten Jahren ausführlich untersucht wurde, auch von der Wissenschaft. So hat bereits 2020 das Leibnitz-Institut eine Studie unter dem Titel „Hate Speech in der Demokratie“ veröffentlich, in der Hassrede auf Facebook, Twitter, Youtube und Instagram untersucht wurde. Tiktok spielte damals noch keine Rolle.

Ergebnis: 4,8% aller Beiträge zu politischen Themen waren hasserfüllt. 62% der Hasskommentare richteten sich gegen Minderheiten (Geflüchtete, Muslime etc.). Das hatte auch damals schon Einfluss auf politische Debatten, etwa auf die Debatte über die Flüchtlingskrise.

Zwei Jahre später, im Jahr 2022, hat die „Landesanstalt für Medien NRW“ den Bericht „Hassrede auf Knopfdruck“ veröffentlicht. Hier wurden die Inhalte und Kommentare auf Medienseiten untersucht. Ergebnis: Fast 15% aller Kommentare wurden als Hassrede eingestuft. Ein dramatischer Anstieg. Auch habe die Hetze gegen Frauen um 138% gegenüber 2017 zugenommen.

Das sind jetzt nur einige Beispiele. Welche Studie man sich auch anschaut: Überall nehmen Hass und Hetze dramatisch zu. Es ist nicht nur gefühlt so, es ist wissenschaftlich belegt.

Twitter ragt besonders heraus

Eine Frage wird in diesem Zusammenhang gerne gestellt: Fallen bestimmte Netzwerke mehr auf als andere?

Durchaus – es kommt allerdings auch darauf an, was man sich genau anschaut. Twitter zum Beispiel, das mittlerweile ja nur noch X heißt, fällt immer häufiger negativ auf. Elon Musk hat rund zwei Drittel der Mitarbeiter nach der Übernahme vor die Tür gesetzt.

Das merkt man der Plattform an: Es gibt zu wenige Menschen, die sich um Hass und Hetze auf der Plattform kümmern. Sowohl was die Moderation betrifft, also die aktive Entfernung von Konten oder Inhalten, als auch was die Pflege und Weiterentwicklung der Software betrifft.

Es gibt jede Menge Zahlen, die das klar belegen: Nach einer Studie des „Centers for Countering Digital Hate“ aus November 2022 haben bereits vier Wochen nach Musks Übernahme die Anzahl der Tweets mit Hassrede, etwa gegenüber Juden und Schwarzen um 58% zugenommen. Die Beleidigungen gegen Schwarze nahm in den USA um 195% zu. Gleichzeitig explodierte auch die Zahl der Fake-News, belegen andere Studien wie einer von der Montclair University.

Musk hatte „Redefreiheit total auf X“ angekündigt. Und er hat geliefert.

Algorithmen bestärken Hass und Hetze auf den Plattformen oft sogar noch

Redefreiheit ist nicht unbeschränkt

Elon Musk ist der Ansicht, dass vollständige Redefreiheit herrschen muss.

Das hört man auch oft von ganz vielen Menschen: Ihr wollt uns doch nur den Mund verbieten… Nicht einfach, da zwischen Gut, Geht-noch und Geht-gar-nicht zu unterscheiden.

Die Redefreiheit ist ein hohes Gut – in den USA geht sie in einigen Punkten sogar weiter als bei uns. Aber wie heißt es so schön: „Hass ist keine Meinung.“ Das stimmt vollkommen, und das muss man sich auch immer wieder klar machen. Wir können nichts unternehmen, wenn jemand bestimmte Menschen oder Menschengruppen hasst – aus welchen Gründen auch immer.

Es ist aber eben etwas anderes, das in aller Öffentlichkeit herauszuposaunen und mit Aufrufen zu verbinden, etwa zur Gewalt oder mit Beleidigungen. Das verstößt eindeutig gegen geltendes Recht. Auch Redefreiheit kann Grenzen. Man darf niemanden beleidigen, nicht zu Hass aufstacheln, hetzen oder Menschgruppen diffamieren. Das steht alles unter Strafe und hat daher schon allein deswegen in „Sozialen Netzwerken“ nichts verloren.

In den eigenen vier Wänden darf man denken und sagen was man möchte, aber eben nicht in der Öffentlichkeit. Und die großen Plattformen sind heute nun mal eine Öffentlichkeit, für jeden zugänglich. Das müssen viele Menschen lernen – und deswegen braucht es Regeln, die auch durchgesetzt werden müssen. Das ist keine Zensur, das ist Rechtspflege.

Hate Speech: Schwierig in den Griff zu bekommen

Die Pflichten der Betreiber und das NetzDG

Aber wie sieht es denn mit den Pflichten der Betreiber aus: Die Plattformen dürfen doch wohl kaum alles zulassen und müssen auch aktiv werden.

Bis 2017 galten mehr oder weniger ausschließlich die Nutzungsbedingungen der jeweiligen Anbieter. Doch bereits im Oktober 2017 wurde in Deutschland das „Netzwerkdurchsetzungsgesetz“ eingeführt, kurz NetzDG.

Das NetzDG verpflichtet Plattformbetreiber von Gesetz her dazu, rechtswidrige Inhalte wie Hassrede, Volksverhetzung, Beleidigungen und andere strafbare Inhalte zu entfernen oder zu sperren, spätestens wenn die Plattformbetreiver davon erfahren – etwa durch die Meldung eines Nutzers.

Damit das auch passiert, legt das NetzDG auch fest, dass die Plattformbetreiber geeignete Maßnahmen ergreifen müssen, um Beschwerden über rechtswidrige Inhalte zeitnah zu bearbeiten. Seit Mitte Februar gibt es in ganz Europa den „Digital Services Act“ (DSA), und der geht deutlich weiter. Das ist ja wichtig, damit sich Plattformen nicht damit herausreden, ein Beitrag käme aus Frankreich, Irland oder woher auch immer.

Der „Digital Services Act“ gilt seit 17. Februar 2024 vollumfänglich

Digital Services Act (DSA)

Der DSA ist deutlich schärfer als das NetzDG und gilt in ganz Europa. Wichtig: Alle Online-Plattformen einer relevanten Größe müssen nutzerfreundliche Meldesysteme für illegale Inhalte, einschließlich Hass und Hetze, einrichten.

Die dürfen also nicht irgendwo versteckt sein, sondern müssen einfach und schnell, am besten direkt in jedem Posting erreichbar sein. Plattformen müssen Meldungen innerhalb von 24 Stunden bearbeiten und gegebenenfalls Maßnahmen ergreifen. Die Plattformen müssen sich nun aber auch erklären: Sie müssen transparent machen, wie sie mit illegalen Inhalten umgehen und müssen regelmäßig über die Anzahl Bericht erstatten.

Und weil auch schon mal zu Unrecht gesperrt oder blockiert wird, haben Nutzer, die mit einer Entscheidung der Plattform über eine gemeldete Inhalte nicht einverstanden sind, Zugang zu einem Beschwerdeverfahren. Weil es schmerzhaft hohe Strafen gibt – die ohne weiteres in die Milliarden EUR gehen können –, sind die Plattformen erkennbar bemüht, die Regeln einzuhalten.

So gehen die Plattformen gegen Hass und Hetze vor

Aber wie genau gehen eigentlich die Plattformen gegen Hass und Hetze vor: Werden sie erst aktiv, wenn jmd. eine Beschwerde einreicht oder untersuchen sie Postings auch schon vorab?

Die großen Social-Media-Plattformen wie Facebook, Twitter und YouTube setzen eine Kombination aus Algorithmen, künstlicher Intelligenz (KI) und menschlichen Moderatoren ein, um gegen Hass und Hetze vorzugehen.

Hier ist ein Überblick über die Ansätze der Plattformen. Dabei wird nach Schlüsselwörter gesucht, die eindeutig nur bei Hass und Hetze vorkommen. Es kommt aber auch KI zum Einsatz, denn Hass und Hetze ist nicht immer einfach zu erkennen.

KI kann Kontext und Bedeutung besser verstehen als ein Algorithmus – kostet aber mehr Energie und Zeit. Deshalb können in der Regel nicht alle Postings eingehend untersucht werden. Gemeldete Beiträge werden dann in der Regel von echten Menschen untersucht. Youtube zum Beispiel beschäftigt nach eigenen Angaben 10.000 Menschen allein für diese Aufgabe. Meta, also die Firma hinter Facebook und Instagram, bringt es auf 35.000 Menschen.

Content-Moderation: alles andere als angenehm

Diesen Job kann man sich wohl kaum reizvoll vorstellen, den ganzen Tag Hass, Hetze und Fake anschauen und beurteilen, ob das rechtlich noch OK ist oder nicht…

Deswegen beschäftigen die Konzerne zumindest für den englischsprachigen Bereich vor allem Menschen in Billiglohnländern wie den Philippinen. Es gibt bedrückende Dokumentationen wie den Dokumentarfilm „The Cleaners“, die diese unmenschlichen Arbeitsbedingungen auch anprangern. Denn diese Menschen müssen ja nicht nur Texte lesen, sondern auch Bilder oder Videos anschauen –und bekommen den ganzen Tag die dunkelsten Seiten der Menschheit zu Gesicht. Ich kann nur empfehlen, sich diesen Film mal anzuschauen – geht kostenlos auf Youtube und in einigen Mediatheken.

Kann KI den Job nicht machen?

Aber es gibt doch KI – und du hast sie auch schon erwähnt. Kann die nicht die Arbeit machen?

Bei den großen Plattformen kommt auch KI zum Einsatz. Nur ist die nicht unbedingt schnell – und teuer. Und sie kann, zumindest noch nicht, in jedem Fall präzise urteilen. Das Gut der Redefreiheit ist wichtig und darf nicht in begründeten Fällen eingeschränkt werden; vor allem dann, wenn gültige Gesetze verletzt werden.

Es ist aber manchmal ein schmaler Grat zwischen Zitatrecht, Kunst, Satire – die in der Regel erlaubt sind – und gesetzeswidrigen Kommentaren oder Bildern. Das kann KI bislang nicht wirklich zuverlässig meistern. Zeigt ein Bild Gewalt und Hass – oder ist es ein Screenshot auf einem Video Game? KI-Experten von Meta sagen: Das lässt sich bislang nicht eindeutig auseinanderhalten.

KI ist ein wirksames Werkzeug in diesem Kampf, keine Frage – aber leider kein Allheilmittel.

So viel kann man sicher sagen: Ohne KI sähe es auf den Plattformen noch viel schlimmer aus. Die KI filtert schon einiges heraus; vor allem jene Posting, die schon bekannt sind und wiederholt geteilt werden. Aber wenn ein neues Video viral geht, in dem – auch mit KI – Stimmen verfremdet werden und Hass und Hetze im Video versteckt sind, das kann KI bislang noch nicht wirklich gut erkennen.

Hasskommentare melden, nicht darauf reagieren

Unternehmen die Plattformen auch genug?

OK, Facebook, Instagram, Tiktok, X und Co. unternehmen also etwas gegen Hass und Hetze – weil der Gesetzgeber sie dazu verpflichtet. Aber unternehmen sie auch genug?

Es ist schwierig, eine eindeutige Antwort darauf zu geben, ob Meta (Facebook), TikTok und X (früher Twitter) genug unternehmen, um Hass und Hetze auf ihren Plattformen zu bekämpfen. Einerseits haben alle drei Unternehmen in den letzten Jahren ihre Bemühungen zur Moderation von Inhalten durchaus erkennbar verstärkt, indem sie in Technologie, Personal und Partnerschaften investiert haben.

Andererseits gibt es aber auch immer noch Hinweise auf Schwächen und Bereiche, in denen Verbesserungen erforderlich sind. Bei Untersuchungen des Verbraucherschutz des US-Ministeriums wurde Meta zum Beispiel bescheinigt, „routinemäßig seine eigenen Richtlinien verletzt, indem es Beiträge zulässt, die den Hass gegen vulnerable und marginalisierte Gruppen anheizen.“ Man kannn wohl nicht sagen, dass der Meta-Konzern genug tut.

Auf anderen Plattformen sieht es aber auch nicht besser aus. Eine Studie des „Institute for Strategic Dialogue“ (ISD) aus dem Jahr 2020 fand auf TikTok eine beträchtliche Menge an extremistischen und hasserfüllten Inhalten, einschließlich der Verherrlichung des Nationalsozialismus und des Holocausts.

Ist es denn absehbar, dass es besser wird?

Nach meiner Einschätzung: Ja. Denn der „Digital Services Act“ (DSA) ist ein scharfes Schwert, da hier Strafen in Milliardenhöhe möglich sind. Die Plattformen müssen jetzt Risikobewertungen durchführen, um zu ermitteln, welche illegalen Inhalte oder schädlichen Aktivitäten auf ihren Plattformen verbreitet werden könnten. Das muss schnell und effektiv geschehen. Und was besonders wichtig ist: Sie müssen Forschern jetzt Zugang zu relevanten Daten geben, damit sie überprüfen können, wie der Status quo konkret aussieht. Insbesondere Meta hat diesen Zugang bislang regelmäßig verweigert hat.

Diese neuen Anforderungen in Kombination mit den hohen Strafen bringt einiges in Bewegung. Es wird Hass und Hetze auf den Plattformen nicht völlig verbannen können – aber seltener machen.

Was kann jeder einzelne tun?

Wie sollen wir Hass und Hetze begegnen, wenn sie uns begegnet? Ignorieren – oder dagegen anschreiben, was lange Zeit empfohlen wurde.

Richtiger Punkt. Vor einigen Jahren haben viele Experten gesagt, man sollte sich gegenüber Hass und Hetze zu Wort melden. „Counter Speech“ wird das genannt – und lange hat auch Mark Zuckerberg als Chef von Facebook und Instagram dazu aufgerufen.

Es gibt Gründe, die dafürsprechen, sozusagen „Einspruch“ einzulegen und öffentlich dagegen zu argumentieren. Denn Hassbotschaften unwidersprochen zu lassen, kann den Eindruck erwecken, dass diese akzeptabel oder sogar mehrheitsfähig sind. Widerspruch kann dem entgegenwirken. Auch lässt man Opfer nicht alleine zurück.

Doch mittlerweile ist klar: Diese Strategie bringt meist wenig und ist oft sogar kontraproduktiv. Zum einen freuen sich die Algorithmen, wenn eine Menge los ist – dann bekommen mehr Menschen solche Postings zu sehen. Und das ist das Letzte, was man möchte.

Auf Trolle und Extremisten mit gefestigter Ideologie ist mit Argumenten ohnehin keinen Einfluss mehr möglich. Counter Speech befeuert Konflikte. Außerdem belasten einen solche Konflikte, und nicht selten wird man selbst zum Ziel für Hassrede. Kurz: Besser lassen!

Hass und Hetze ist auch ein gesamtgesellschaftliches Problem

Hass und Hetze im Netz unbedingt melden

Aber irgend etwas muss man doch unternehmen können?

Auf jeden Fall. Motto: Melden statt Antworten. Nutzer sollten Hass und Hetze konsequent den Plattformbetreibern melden, damit die Inhalte geprüft und gelöscht werden. Das schützt Betroffene und entzieht Hass die Bühne.

Wer selbst Gift und Galle spuckt – und mit der Zeit verschieben sich auch bei einem selbst die Grenzen –, ist definitiv nicht Teil der Lösung, sondern wird Teil des Problems. Besser ist es, Betroffenen beizustehen, das geht auch mit direkten Nachrichten. Außerdem empfiehlt es sich – so schwierig das mitunter auch ist –, selbst in Kommentaren und Diskussionen so respektvoll wie möglich zu sein und frühzeitig für ein respektvolles, konstruktives Gesprächsklima zu sorgen. Das ist nicht immer leicht, das gebe ich zu. Aber es ist auch besser für das eigene Karma… 😉

Dokumentarfilm „The Cleaners“

https://www.bpb.de/mediathek/video/273199/the-cleaners/

Hassrede auf Knopfdruck (LfM NRW)

https://www.medienanstalt-nrw.de/hass.html

Racism, Hate Speech, and Social Media: A Systematic Review and Critique

https://journals.sagepub.com/doi/full/10.1177/1527476420982230

Gegenrede mit Netz und Verstand (Amadeu Antonio Stiftung)

https://www.amadeu-antonio-stiftung.de/gegenrede-mit-netz-und-verstand/

Umgang mit Hate Speech (Bundeszentrale für politische Bildung)

https://www.amadeu-antonio-stiftung.de/gegenrede-mit-netz-und-verstand/

Angaben zu Aufwand für Moderation (Facebook)

https://about.fb.com/news/2019/11/community-standards-enforcement-report-nov-2019/

Initiative gegen Hass und Hetze:

https://www.initiative-toleranz-im-netz.de/

Hate Speech. Hass und Hetze im Netz als Thema des Kinder- und Jugendmedienschutzes

https://www.nomos-elibrary.de/10.5771/0170-5067-2017-1/jms-jugend-medien-schutz-report-jahrgang-40-2017-heft-1?page=1