Google hat mit Gemini 3 Flash ein KI-Modell vorgestellt, das zeigt: Schneller und effizienter schlägt manchmal größer und teurer. Was das neue Modell kann, wo es an Grenzen stößt und warum es für die meisten Nutzer die bessere Wahl sein könnte.

Die KI-Branche hat sich in den letzten Monaten in einen Wettlauf um immer größere, leistungsstärkere Modelle gestürzt. Mehr Parameter, mehr Rechenleistung, mehr Kosten. Google geht mit Gemini 3 Flash jetzt einen anderen Weg – und könnte damit einen Nerv treffen.

Von 2.5 direkt zu 3: Was steckt dahinter?

Google hat die Versionsnummer von 2.5 direkt auf 3 hochgeschraubt. Das klingt erstmal nach Marketing-Taktik, hat aber einen guten Grund: Die 3er-Generation bringt fundamentale Verbesserungen, besonders beim Reasoning – also der Fähigkeit, komplexe Probleme zu durchdenken und zu lösen.

Gemini 3 Flash ist dabei das Mittelgewicht der neuen Familie. Über ihm steht Gemini 3 Pro für maximale Intelligenz, und es gibt einen speziellen „Deep Think“-Modus für besonders knifflige Aufgaben. Flash positioniert sich als der Allrounder für den Alltag.

Geschwindigkeit trifft Intelligenz

Die zentrale Innovation von Gemini 3 Flash liegt in der Kombination: Das Modell ist dreimal schneller als sein Vorgänger Gemini 2.5 Pro – liefert dabei aber bessere Ergebnisse. Das ist keine Kleinigkeit. Wer schon mal mit KI-Chatbots gearbeitet hat, kennt das Problem: Man wartet. Und wartet. Und wartet.

Bei Flash reagiert das System praktisch in Echtzeit. Besonders bei interaktiven Anwendungen macht das einen riesigen Unterschied. Stellt euch vor, ihr entwickelt eine App, die auf KI-Antworten angewiesen ist. Wenn jede Anfrage drei Sekunden statt einer braucht, merken das eure Nutzer sofort – und sind möglicherweise schnell genervt.

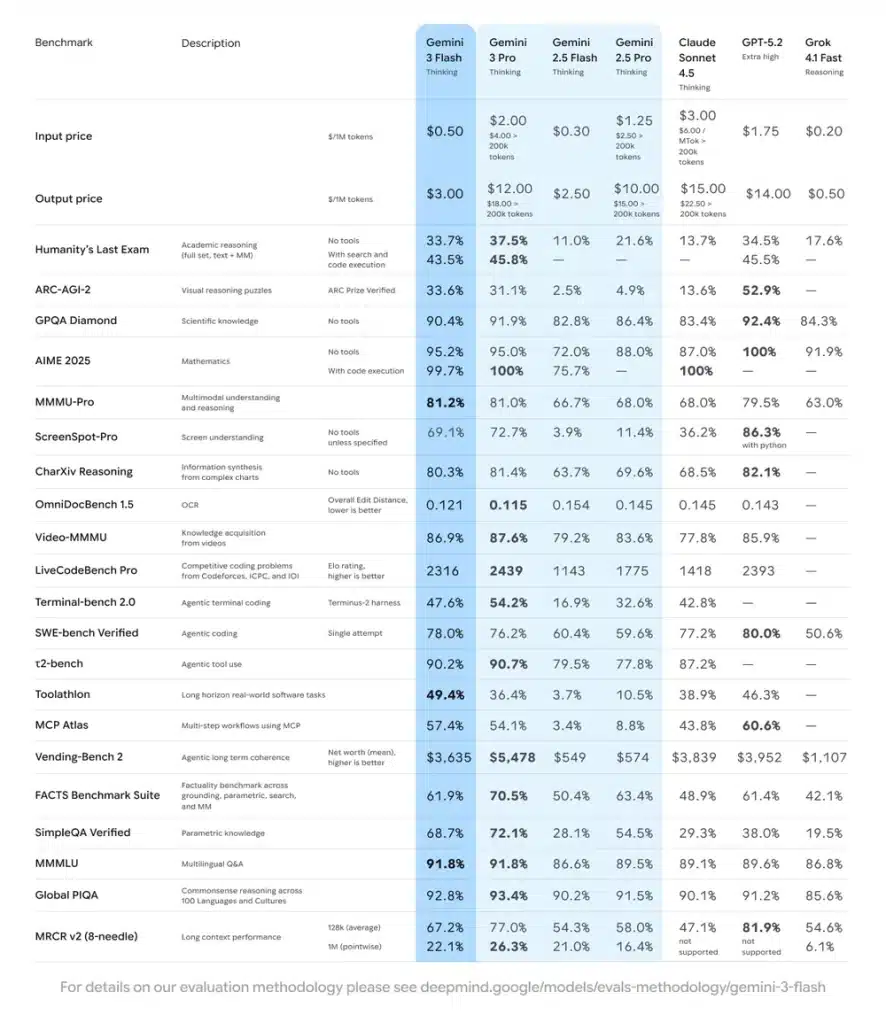

Benchmarks: Die nackten Zahlen

Auf dem Papier sehen die Werte beeindruckend aus. Bei GPQA Diamond, einem Benchmark für wissenschaftliches Reasoning auf PhD-Niveau, erreicht Gemini 3 Flash 90,4 Prozent. Das sind Werte, die man sonst nur von den großen, teuren Pro-Modellen kennt.

Noch interessanter: Beim SWE-bench Verified, einem Test speziell für Coding-Aufgaben, schafft Flash 78 Prozent – und liegt damit sogar vor Gemini 3 Pro. Das ist bemerkenswert, denn Coding ist genau der Bereich, in dem viele Entwickler KI täglich einsetzen.

Bei MMMU Pro, einem Benchmark für multimodales Verständnis, erreicht Flash 81,2 Prozent. Multimodal bedeutet: Das Modell kann nicht nur Text verarbeiten, sondern auch Bilder, Videos und Audio verstehen und daraus Schlüsse ziehen.

Das Geheimnis: Variable Denktiefe

Wie schafft Google es, gleichzeitig schneller und besser zu sein? Die Antwort liegt in einem cleveren Trick: Gemini 3 Flash passt seine Denktiefe dynamisch an die Aufgabe an.

Bei einfachen Fragen bleibt das Modell schlank und schnell. Bei komplexeren Problemen schaltet es automatisch in einen intensiveren Denk-Modus. Das Ergebnis: Im Durchschnitt nutzt Flash 30 Prozent weniger Tokens als Gemini 2.5 Pro – und ist trotzdem präziser.

Tokens sind die Recheneinheiten, in denen KI-Modelle arbeiten. Weniger Tokens bedeuten nicht nur geringere Kosten, sondern auch schnellere Antworten. Google hat hier einen echten Effizienz-Gewinn erzielt.

Multimodal in der Praxis

Die multimodalen Fähigkeiten von Gemini 3 Flash gehen über simples Bilderkennen hinaus. In Demos hat Google gezeigt, wie das Modell Videos analysiert und konkrete Handlungsempfehlungen gibt.

Ein Beispiel: Ihr filmt euren Golf-Schwung und ladet das Video hoch. Flash analysiert eure Bewegung, erkennt Schwachstellen und gibt euch präzise Tipps zur Verbesserung – in wenigen Sekunden. Das funktioniert nicht nur bei Sport, sondern bei allen visuellen Aufgaben.

Oder ein anderes Szenario: Ihr zeichnet etwas auf ein Whiteboard, und Flash erkennt schon während des Zeichnens, was ihr vorhabt, und macht Vorschläge zur Vervollständigung. Diese Art von Echtzeit-Interaktion war bisher eher Science-Fiction.

Wo Flash an Grenzen stößt

So beeindruckend die Zahlen auch sind – Flash ist kein Alleskönner. Google selbst sagt klar: Wenn ihr mehrstufiges, tiefes Reasoning über längere Zeit braucht, sind Gemini 3 Pro oder der Deep Think-Modus die bessere Wahl.

Flash ist optimiert für Geschwindigkeit und Effizienz. Bei strategischen Analysen, wo es wirklich um komplexes Durchdenken geht, merkt man die Kompromisse. Das Modell ist der Sprinter, nicht der Marathonläufer.

Für etwa 90 Prozent der typischen KI-Aufgaben reicht Flash aber vollkommen aus: schnelle Recherchen, Texte schreiben, Code generieren, Bilder analysieren, Zusammenfassungen erstellen. All das funktioniert hervorragend.

Verfügbarkeit und Preise

Google rollt Gemini 3 Flash aktuell weltweit aus. In der Gemini App und im AI Mode von Google Search ist es bereits das Standard-Modell – und kostenlos nutzbar. Jeder kann es also sofort ausprobieren, ohne einen Cent zu zahlen.

Für Entwickler ist Flash über die Gemini API, Google AI Studio, Vertex AI und andere Plattformen verfügbar. Dort kostet es 0,50 Dollar pro Million Input-Tokens und 3 Dollar pro Million Output-Tokens. Das ist deutlich günstiger als vergleichbare Modelle der Konkurrenz.

Zum Vergleich: Ein typischer Blogpost wie dieser hier umfasst etwa 1.000 bis 1.500 Tokens. Man kann mit Flash also sehr viel Content generieren, bevor nennenswerte Kosten entstehen.

Was das für uns bedeutet

Gemini 3 Flash zeigt einen wichtigen Trend: Die KI-Entwicklung geht nicht mehr nur in Richtung „größer, stärker, teurer“. Stattdessen sehen wir eine Ausdifferenzierung. Unterschiedliche Modelle für unterschiedliche Aufgaben.

Das ist gut für uns alle. Nicht jede Anfrage braucht die maximale Rechenpower. Manchmal reicht ein schnelles, effizientes Modell vollkommen aus – und spart dabei Zeit, Energie und Kosten.

Die Kunst wird sein, das richtige Werkzeug für die jeweilige Aufgabe zu wählen. Genau wie ein Handwerker nicht für jede Schraube den größten Akkuschrauber rausholt, sollten wir lernen, das passende KI-Modell zu wählen.

Fazit: Flash ist der neue Standard

Gemini 3 Flash dürfte für die meisten Nutzer zur ersten Wahl werden. Es ist schnell genug für interaktive Anwendungen, intelligent genug für anspruchsvolle Aufgaben und günstig genug für den breiten Einsatz.

Google hat hier etwas Cleveres geschafft: Ein Modell zu bauen, das in der Praxis besser funktioniert als theoretisch leistungsstärkere Konkurrenten – einfach weil es schneller ist und sich besser anfühlt.

Probiert es aus. Die Chancen stehen gut, dass ihr bei Flash bleibt.