02.11.2018 | Digital

Die Herkunft eines Menschen – ob Land, Ort oder sogar nur Stadtteil – beeinflusst maßgeblich seine Sicht auf die Welt. In vielen Ländern beschäftigen sich Ethikräte mit unterschiedlichsten Fragestellungen, seien sie rechtlich, naturwissenschaftlich, religiös oder medizinisch.

(mehr …)

25.05.2018 | Internet

Alle reden über Digitalisierung – aber wie sieht es mit den Basics in diesem Bereich aus? Wer Computer programmieren kann, der weiß, was ein Algorithmus ist. Aber alle anderen? Die Bertelsmann Stiftung wollte es genauer wissen und hat für eine Studie erforscht, was die Deutschen über Algorithmen wissen. Die erschreckende Erkenntnis: Rund die Hälfte der Deutschen weiß überhaupt nicht, was ein Algorithmus ist. Nur ein Bruchteil kann erklären, was das ist. Dabei regieren Algorithmen heute die Welt.

(mehr …)

06.03.2017 | Tipps

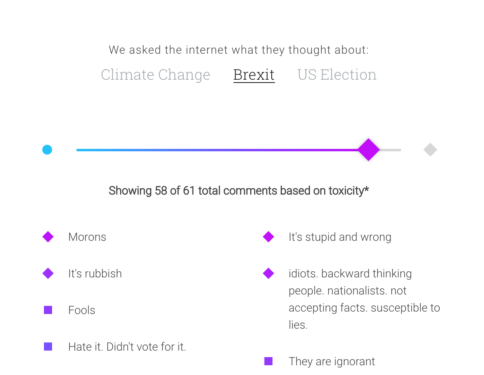

Was hat uns das Internet an Freiheit gebracht: Jeder kann offen seine Meinung sagen/schreiben/zeigen. Meinungsaustausch mit der ganzen Welt – wunderbar. Funktioniert aber nur dann gut, wenn sich die Menschen gegenseitig respektieren.

Aber die traurige Erkenntnis ist: Der Mensch neigt zum Missbrauch. Im Schutze der Anonymität wird gepöbelt, angefeindet, aufgehetzt, getrollt und gelogen – und das leider immer öfter und immer intensiver. Das Netz verfielfältig das Gute wie das Schlechte. Fakten und Wahrheiten werden von jedem selbst gemacht – und tatsächlich diskutieren, Argumente austauschen, das kommt immer seltener vor, tritt häufig in den Hintergrund.

Twitter will mit Algorithmen arbeiten

Im Silicon Valley setzt man zum Lösen von Problemen auf Technik. Auch beim Lösen von Problemen, die durch Technik ert entstanden sind. Facebook zum Beispiel versucht, mit geeigneten Algorithmen sogenannte Fakenews zu enttarnen. Einen ähnlichen Weg will jetzt Twitter beschreiten: Twitter hat sich lange überhaupt nicht um das Problem gekümmert.

Jetzt aber will Twitter mit Algorithmen gegen Hasskommentare vorgehen: Software soll beurteilen, ob Tweets angemessen sind oder nicht. In den Suchergebnissen der „Safe Search“ sollen fragwürdige Tweets nicht mehr auftauchen. Was aber zwangsweise dazu führen wird – ein Problem jeder Filtertechnologie -, dass auch Tweets weggeblendet werden, die das nicht verdient haben.

Twitter will auffällige Accounts weniger gut sichtbar machen: Nur konkrete Follower sollen die Tweets sehen, wenn ein Algorithmus der Ansicht ist, hier würde es nicht mit rechten Dingen zugehen. Für alle anderen bleiben die Inhalte unsichtbar.

Der große Wurf wird das also nicht werden, was Twitter da angekündigt hat. Es wird nur an den Symptomen herumgedoktert, nicht am Problem an sich. Das – zugegeben! – allerdings von den Sozialen Netzwerken selbst auch nicht ohne weiteres gelöst werden kann. Sie sind sozusagen selbst das Problem: Denn hier kann nun mal jeder alles sagen – und viele machen das eben einfach auch.

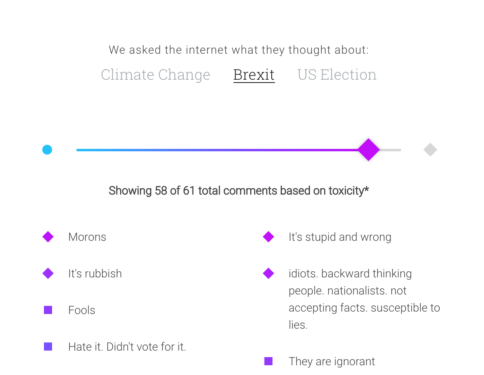

Google Perspective will Trolle enttarnen

Auch Google hat einen Algorithmus entwickelt, der für mehr anspruchsvolle Kommentare in Foren und Blogs sorgen soll. Google Perspective heißt das Angebot, das als Programmierschnittstelle (API) kostenlos zur Verfügung steht – und nun von jedem genutzt werden kann.

Die Idee: Ein selbstlernende Software kontrolliert jeden neuen Forumseintrag, ob er Pöbeleien oder Angriffe enthält – oder ob er sich inhaltlich mit einem Text oder Kommentare eines Vorgängers auseinandersetzt. So wie ein Spam-Filter beurteilt, ob ein Eintrag eher Spam (Werbung) ist oder nicht, legt Google Perspective mit einem Score (Punktesystem) fest, ob ein Kommentar eher angemessen oder unangemessen ist.

Hilfe beim Aufräumen

Anschließend kann die Forums-Software oder der Betreiber entscheiden, ob der Kommentar erscheint oder unterdrückt wird. Das System lernt dazu, unter anderem, indem Foren der New York Times ausgewertet werden. Hier sortieren auch Menschen Beiträge heraus.

Die Software lernt so, welche Begriffe „giftig“ sind und welche nicht – und in welchem Kontext. Das Projekt scheint mir einen guten Ansatz zu haben. Es steht noch am Anfang, könnte aber dafür sorgen, die Flut von unangmessenen Kommentaren einzudämmen – und damit möglicherweise auch die Motivation, einfach drauf los zu trollen oder Social Bots zu entwickeln.

Erst lesen, dann kommentieren

Interessant ist aber auch der Ansatz der norwegischen Tech-Blogs NKRBeta: Wer hier einen Beitrag kommentieren möchte, muss kurz vor dem Ausfüllen der Kommentarspalte in einem Miniquizz zwei, drei Fragen beantworten – und zwar keine Rechenaufgaben, sondern Fragen zum Inhalt des Textes.

Die Idee: Nur, wer den Text wirklich gelesen hat (und nicht nur Headline und zwei Sätze), kennt die Antworten. Die Erfahrung der Redakteure: Wer einen Text komplett liest und versteht, neigt weniger zu Pöbeleien und Agitation. Grundsätzlich eine schöne Idee. Bedeutet aber natürlich aber auch mehr Aufwand für jeden, der etwas kommentieren will.

09.12.2016 | Tipps

„Big Data“ geistert als Begriff schon lange durch die Medien. Es werden immer größere Datenmengen angehäuft – und die kann man nutzen oder missbrauchen.

Doch jetzt wurde der Verdacht laut, Big Data hätte Donald Trump zum Präsidenten gemacht. Durch die geschickte Analyse großer Datenmengen. Weil man doch heute irgendwie jeden „durchleuchten“ kann – oder manipulieren. Ein Artikel in der Wochenendbeilage Das Magazin einiger Schweizer Tageszeitungen hat die Diskussion angekurbelt – und für jede Menge Gesprächsstoff diese Woche geführt.

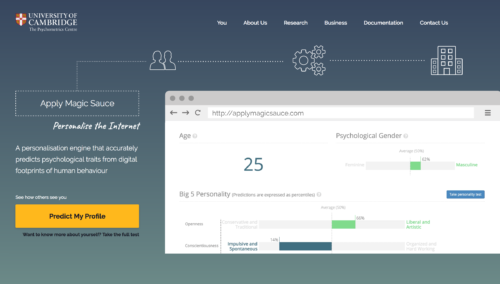

Das relative neue Unternehmen Cambridge Analytica ist auf die Analyse von Daten spezialisiert und hier auf die psychologische Begutachtung von Daten. Jeder Mensch hinterlässt bei der Nutzung von Onlinediensten und sozialen Netzwerken Spuren. Klar, wer „Paris“ in die Suchmaschine eintippt, interessiert sich für Paris. Das ist trivial.

Matrix oder Lady Gaga?

Aber wer hätte gedacht, dass es einen Unterschied macht, ob man einen Film wie „Matrix“ liked oder die Musik von Lady Gaga? Ein Like bei einer bestimmten Kosmetikmarke bedeutet mit hoher Wahrscheinlichkeit, dass jemand schwul ist – wenn der Liker ein Mann ist. Lady Gaga hören eher extrovertierte Menschen. Philosophie wird eher von introvertierten Menschen geliked.

Da kommt einiges zusammen, wenn man bedenkt, was wir alles so liken. Diese Daten, kombiniert mit öffentlich zugänglichen Daten ergeben einen beeindruckenden Datenpool. Daraus lassen sich erstaunlich konkrete Profile erstellen: Angeblich kennt das Unternehmen die inimsten Details jeden erwachsenen US-Amerikaner, das sind 220 Millionen Menschen.

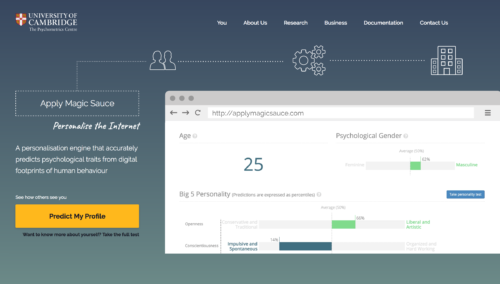

Was sich anhand der über Facebook frei zugänglichen Daten so alles über einen sagen lässt, zeigt dieser Onlinetest: Apply Magic Sauce. Hier kann man sehen, wie einen der Algorithmus einschätzt, abhängig davon, was man geliked hat und was nicht.

Jeder ist anders – und will anders angesprochen werden

Aber was nutzt es zu wissen, ob jemand Outdoor-Fan ist, gerne Lady Gaga hört oder eher das Jagen liebt? Ganz einfach: Weil man jeder Person dann die Botschaften präsentieren kann, die optimal zum Typ passt. Anstatt alle weißen Frauen mit derselben Kernbotschaft zu konfrontieren, bekommt jeder mehr oder weniger eine individuelle Botschaft.

So manche Trump-Aussage wurde in hunderttausend Varianten zu den potenziellen Wählern gebracht. Meist wurde nur etwas im Detail verändert, etwa die Farbe der Schrift, hier ein Wort, da ein Wort. Thema Waffenbesitz: Ängstliche Menschen bekommen ein Foto von einem Einbruch zu sehen, abenteuerlustige ein Bild von der Jagd. Die Kernbotschaft ist dieselbe: Das Recht auf Waffenbesitz. In der Tat lassen sich mit heutigen Mitteln relativ einfach solche individualisierten Nachrichten rausposaunen.

Trump zum Sieg verholfen?

Und das soll also der entscheidende Punkt gewesen sein, der Donald Trump zum Sieg verholfen hat? Dieser Eindruck wird in dem ersten Text von „Das Magazin“ tatsächlich erweckt. Der Erfinder der Datenanalyse wird zum Präsidenten-Macher erklärt. Als wäre es unausweichlich, dass man alles erreichen kann, wenn man nur über genügend Daten und den entschlossenen Willen verfügt, diese Macht auch zu nutzen.

Es ist zweifellos richtig, dass heute extrem detaillierte Analysen möglich sind – und auch, Stichwort Filterblase, jeder mit genau den News versorgt werden kann, die ihn interessieren. Allerdings gibt es nicht die geringsten Belege dafür, dass diese Methoden erfolgreich oder gar entscheidend waren. Viele Beobachter erklären es sich schlichtweg damit: Es kann ja gar nicht anders sein, als dass Manipulation im Spiel ist, ich kann mich doch nicht geirrt haben.

Hat die Methode funktioniert?

Diesen Beweis gibt es eben nicht. Es kann auch keinen Beweis dafür geben. Hier übertreiben viele Artikel und Onlinemagazine. Sascha Lobo, der Internetaktivist und Kolumnist bei Spiegel Online, spricht vom „magischen Digitalismus“. Es gebe einen Trend, „der Maschine, dem Algorithmus magische Fähigkeiten zuzuschreiben.

Also eine Art Technoesoterik, die sowohl aus Unwissen wie auch aus dem Wissen samt Überschätzung des eigenen Sachverstands entstehen kann.“ Lobo sieht die Gefahr durch diesen Digitalaberglauben übrigens aus beiden Richtungen: sowohl auf der Seite der Unwissenden, als auch aus der Hybris der Wissenden.

Auch in Deutschland möglich?

Wäre das eigentlich generell auf Deutschland oder Europa übertragbar? Ja und Nein. Die grundsätzliche Vorgehensweise, also das Bewerten von Verhalten, etwa wo wir Likes setzen und wo nicht, funktioniert in Deutschland natürlich genauso gut wie in den USA. Allerdings ist es damit allein nicht getan. Gerade wenn es darum geht, konkret für die Wahl etwas zu unternehmen, bräuchte es noch mehr Informationen.

In den USA hat Cambridge Analytica jede Menge Datensätze gekauft, etwa Daten aus Grundbucheinträge, Bonuskarten, Wählerverzeichnisse, Clubmitgliedschaften, Zeitschriftenabonnements, medizinische Daten und vieles mehr. Solche Saten sind in den USA durchaus zu kaufen.

In Deutschland teilweise auch, aber bei weiterem nicht so viele wie dort. Es gibt strengeren Datenschutz, deshalb wären die Profile, die man erstellt, schon mal schlechter. Abgesehen davon ist diese Vorgehensweise recht teuer. Deutsche Parteien hätten gar nicht das Geld dafür. Und: Es würde auch aus moralischen Gründen wohl eher kein Gebrauch davon gemacht. Insgesamt wenig vorstellbar, dass zumindest die demokratischen Parteien von solchen Methoden Gebrauch machen würden. Solche Parteien, die gemeinhin als „populistisch“ bezeichnet werden, könnte man das eher zutrauen. Aber die könnten sich das wohl kaum leisten.

Also Entwarnung?

Also Entwarnung auf ganzer Linie? Hier in Europa sind wir selig – und es kann uns nichts passieren? Nein, im Gegenteil. Auch wenn die Geschichte vermutlich auf aufgebauscht wurde: Es kann keinen Zweifel geben, dass es die Möglichkeit zum Missbrauch von Big Data gibt, auch zum massenhaften Missbrauch.

Die genauen Schilderungen, wie Psychometrie funktioniert und welche Möglichkeiten damit zumindest grundsätzlich verbunden sind, sollten uns aufrütteln. Wir sollten uns fragen, wieso es eigentlich erlaubt ist, dass so etwas gemacht wird? Dass es Firmen gibt, die derart konkrete Profile erstellen und diese auch noch zu Manipulationszwecken missbrauchen?

Das geht weit über personalisierte Werbung hinaus, auch wenn die Prinzipien dieselben sind. Das Ziel ist ein anderes. Firmen sollten damit kein Geld verdienen dürfen. Hier ist die Politik gefordert. Aber nicht, indem solche Methoden für den Wahlkampf genutzt werden, sondern indem ein solches Treiben unterbunden wird. Es könnte schlichtweg verboten sein – und sollte es auch –, Menschen derart auf die „Pelle“ zu rücken, ihnen sozusagen in den Kopf zu schauen. Bloß weil es möglich ist, muss es ja nicht erlaubt sein. Man kann auch eine Wohnung heute mit geringem technischen Aufwand abhören – aber es ist aus gutem Grund verboten.

01.07.2016 | Tipps

Über 1,6 Milliarden Menschen nutzen mittlerweile Facebook – und viele verlassen das Netzwerk kaum noch. Sie lesen nicht nur, was Freunde oder Bekannte so schreiben, sondern lesen auch Nachrichten und News gleich im sozialen Netzwerk. Was aber sicher jedem schon mal aufgefallen ist: Nicht alles, was Freunde oder befreundete Webseiten posten, erscheint in der eigenen Timeline.

Ein Facebook-Algorithmus entscheidet, was aus dem Wust der Neuheiten, News und Posts relevant ist und in jeder einzelnen Timeline auftaucht. Dieser Algorithmus wird jetzt verändert: Posts von engen Freunden und Familie sollen jetzt besser sichtbar werden. Das bedeutet aber auch, dass andere Dinge weniger Reichweite bekommen – und darüber machen sich vor allem News-Anbieter Sorgen.

Wie entscheidet Facebook eigentlich, welche Postings in der Timeline auftauchen?

Facebook hat einen Algorithmus, also ein Computerprogramm, das entscheidet für jeden einzelnen von uns, welche Postings und welche News in der Timeline auftauchen. Denn es erscheint keineswegs alles, das wäre zu viel, argumentiert Facebook.

Deshalb wählt der Algorithmus, was uns wahrscheinlich interessiert. Oder besser: Worauf wir wahrscheinlich reagieren, wo wir klicken, was wir liken, wo also etwas passiert, denn das will Facebook, dass etwas los ist. Je mehr Interaktion, desto besser,

Aber nun wird der Algorithmus ja im Detail abgeändert. Was hat Facebook angekündigt?

Die Postings von engen Freunden, mit denen ich mich austausche, haben in Zukunft eine größere Wahrscheinlichkeit in der Timeline aufzutauchen als die von entfernten Bekannten, die kaum jemanden interessieren. Dasselbe gilt für News aus Redaktionen oder von Firmen: Was keine Likes oder Kommentare erzeugt, erscheint seltener in den Timelines als andere Postings. Auch Fotos und Videos sind hilfreich. Nun will Facebook den Algorithmus anpassen: Das, was gute Freunde und Familie postet, soll öfter und prominenter platziert werden. Motto: Friends and Family first.

Wenn einige Postings besser und prominenter auftauchen, dann muss es ja auf Kosten von anderen Postings passieren. Welche sind das, welche News und Posts tauchen künftig seltener in der Timeline auf?

Es sind wohl eher die Postings von Webseiten, Marken, Firmen oder News-Diensten. Vor allen News-Dienste fürchten um Reichweite. Es könnte passieren, dass sie deutlich weniger gelesen werden. Facebook sagt zwar, das wird sich in Grenzen halten, aber es muss Reichweitenverluste geben.

Weniger Nachrichten, mehr Menschelndes: Das ist das Credo für die Zukunft. Das bedeutet dann aber auch, dass vor allem Nachrichten, die kein Mainstream sind, keine Aufreger, alles, was nicht in die Kategorie Klick-mich-sofort-an gehört, in Zukunft eher schlechte Karten hat.

Was bedeutet das denn für Nachrichten-Anbieter?

Weniger Reichweite ist nie gut, jeder will möglich viel wahrgenommen werden und Reaktionen auslösen. Es gibt verschiedene Lösungen: Man kann News verbreiten, die Aufmerksamkeit erzeugen, die zum Teilen animieren. Das sind aber oft eher die flachen News, Boulevard, Belanglosigkeiten, die die Leute aber ansprechen.

Darauf werden sich die Inhalteanbieter mehr stürzen. Alles, was relevant sein könnte, aber gegen den Strom ist, außerhalb der Filterblase, hat es in Zukunft noch schwerer als bislang ohnehin schon. Die Verlockung zur seichten Berichterstattung ist groß.

Außerdem gibt es für jeden die Möglichkeit, sich Aufmerksamkeit zu kaufen: Man kann Postings sichtbarer machen, indem man Facebook dafür bezahlt. Klar, dass Facebook das besonders gerne sieht. Damit verdient das Netzwerk seine Brötchen. Last not least ist es auch möglich, seine Inhalte bei Instant Articles einzustellen, also dem Verteildienst von Facebook. Da wird man sichtbarer, verliert aber die vollständige Kontrolle. Sieht also alles nicht so gut aus für Inhalteanbieter.

Wird Facebook damit seiner gesellschaftlichen Verantwortung gerecht?

Welche Verantwortung? Davon will man bei Facebook nichts wissen. Es geht Mark Zuckerberg nicht darum, möglichst ausgewogene Standpunkte zu verteilen, geistreiche Gedanke zu fördern oder sich für Kultur einzusetzen. Die Aktionäre müssen zufrieden sein, es muss was los sein im Netzwerk. Deswegen gewinnt immer, was laut ist, was aufregt – und das sind selten die klugen Gedanken.

Facebook ist eine Geschrei-Verteil-Maschine, die Geld einbringt. Qualität wird bestraft, gesellschaftliche Relevanz ebenso. Entertainment und Ablenkung wird belohnt. So ist das leider. Sehr unerfreulich. Außerdem versucht Facebook auf diese Weise, Verlage und Inhalteanbieter noch stärker an sich zu binden. Das kann nicht gesund sein.

29.08.2011 | Tipps

Kaum jemand macht sich Gedanken darüber, wie eine Suchmaschine eigentlich funktioniert. Dabei ist das eine äußerst interessante Angelegenheit: Suchmaschinen müssen nicht nur schnell sein und aktuelle Ergebnisse liefern, sondern idealerweise auch die am besten passenden Webstellen präsentieren.

Eine Reihe Ingenieure tüftelt an den Suchalgorithmen und versucht sie ständig zu verbessern. Was mich erstaunt hat: Angeblich gibt es rund 500 Veränderungen pro Jahr an diesen Algorithmus, in der Regel kleinere Eingriffe, aber das sind eben fast zwei Änderungen pro Tag.

In einem Video erklären die Experten, was sie machen – und welchen Herausforderungen sie sich stellen müssen.

httpv://www.youtube.com/watch?v=J5RZOU6vK4Q