Wer bei Twitter einen Tweet postet, der mit einem Foto garniert ist, muss mitunter zusehen, wie Twitter das Foto beschneidet – damit es perfekt in die Timeline der User passt. Der Algorithmus, der den passenden Ausschnitt bestimmt, scheint nicht über jeden Zweifel erhaben. User haben Auffälligkeiten entdeckt, die auf eine mögliche Form der Diskriminierung hinweisen.

Wie mächtig Algorithmen sind, fällt uns immer nur dann auf, wenn etwas Ungewöhnliches oder Dramatisches passiert. Oder wenn sich jemand intensiv damit beschäftigt – und intelligent die Ergebnisse in Frage stellt.

Genau das haben am Wochenende einige User getan: Sie haben emsig auf Twitter Fotos verteilt und geschaut, wie die Twitter-Algorithmen damit umgehen. Denn wenn Fotos nicht die perfekten Maße haben – also 16:9 -, werden sie von Twitter-Algorithmen automatisch „bearbeitet“, damit sie in die Timeline passen.

Die Algorithmen schneiden die Fotos dann zu (Fachbegriff: croppen). Nur ein Ausschnitt taucht in der Timeline auf. Aber welcher Ausschnitt soll das sein? Darüber entscheidet der Twitter-Algorithmus. Er legt fest, welcher Teil des hochgeladenen Fotos oder Bildes erst mal zu sehen ist. Erst wenn ein User auf die Preview klickt, erscheint das komplette Bild.

Die Hautfarbe spielt bei Twitter eine Rolle

Helle Hautfarbe setzt sich fast immer durch

Dazu haben die forschungshungrigen Probanden Fotos ausgesucht, die – zugegebenermaßen – extrem sind: ungewöhnliche lange Bilder zum Beispiel, 20 Mal länger als breit.

Da hat der Twitter-Algorithmus die Qual der Wahl: Welcher Ausschnitt ist relevant? Um das herauszufinden, haben die Probanden diverse lange Fotostreifen gepostet. Oben ein Gesicht – und unten ein Gesicht. Dazwischen ganz viel Platz.

Doch welches Gesicht wählt Twitter? Immer das obere? Oder immer das untere? Es ist immer ein anderes – und auffällig häufig das Gesicht mit der hellen Hautfarbe.

Effekt tritt sogar bei Comic-Figuren ein

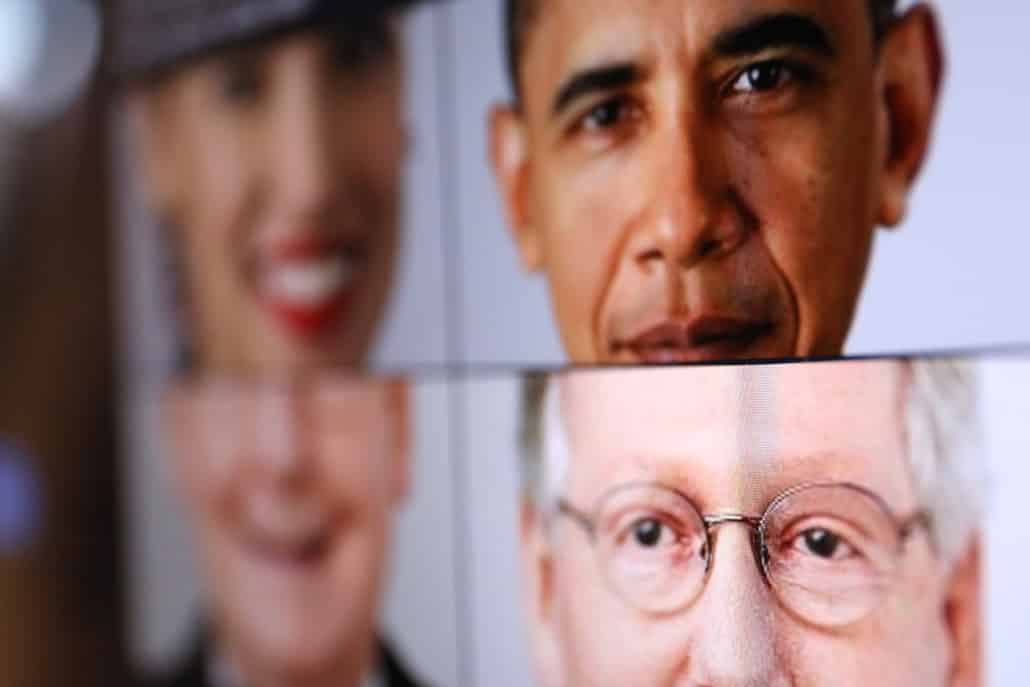

Ein Fotostreifen etwa mit Ex-Präsident Barack Obama und Republikaner Mitch McConnell hat sehr häufig zur Folge, dass Twitter nur das helle Gesicht zeigt, nicht das von Barack Obama. Egal, ob der oben oder unten zu sehen ist, mit oder ohne Krawatte. Das funktioniert sogar mit Comic-Figuren.

Eine mögliche und in der Diskussion auch präsentierte Erklärung: Die Algorithmen erkennen weiße Gesichter eher als Gesicht als dunkle. Ein typischer Bias: Weil die KI-Systeme mit mehr Fotos von hellen Menschen trainiert wurden/werden, erkennen sie Gesichter von Menschen mit dunkler Hautfarbe schlechter.

Dass so etwas häufig ein Problem ist, ist längst bekannt. Aber dass es selbst bei einem prominenten Dienst wie Twitter derart akut und konkret sein könnte, überrascht dann doch.

Twitter: kein grundsätzliches Problem

Begonnen hat das Experimente mit dem Problem eines Nutzers: Ein dunkelhäutiger Kollege hatte Schwierigkeiten, in einem Zoom-Chat einen beliebigen Hintergrund zu wählen. Als das auf Twitter dokumentiert werden sollte, zeigte Twitter in der Mobilansicht ebenfalls nur den Bildausschnitt mit dem hellen Gesicht.

Twitter selbst hat die Herausforderung immerhin angenommen: Twitter-Pressesprecherin Liz Kelley erklärt, die Entwickler des Netzwerks würden sich das Phänomen genauer anschauen.

Ein grundsätzliches Problem von Rassismus oder Geschlechterungerechtigkeit wollte das Unternehmen nicht einräumen. Es wurden aber weitere Tests und Analysen versprochen, die offen gelegt werden sollen.

[av_video src=’https://vimeo.com/422364323′ mobile_image=“ attachment=“ attachment_size=“ format=’16-9′ width=’16‘ height=’9′ conditional_play=“ av_uid=’av-7tx7h0f‘]