Stellt euch vor, ihr kopiert einen Text aus ChatGPT und fügt ihn in ein Dokument ein – ohne zu ahnen, dass unsichtbare digitale Fingerabdrücke mitreisen. Genau das ist bei den neuesten ChatGPT-Modellen passiert. Was zunächst wie eine ausgeklügelte Überwachungsfunktion aussah, entpuppte sich als unbeabsichtigter Nebeneffekt modernster KI-Technologie.

Der Auslöser: Studenten entdecken das Unmögliche

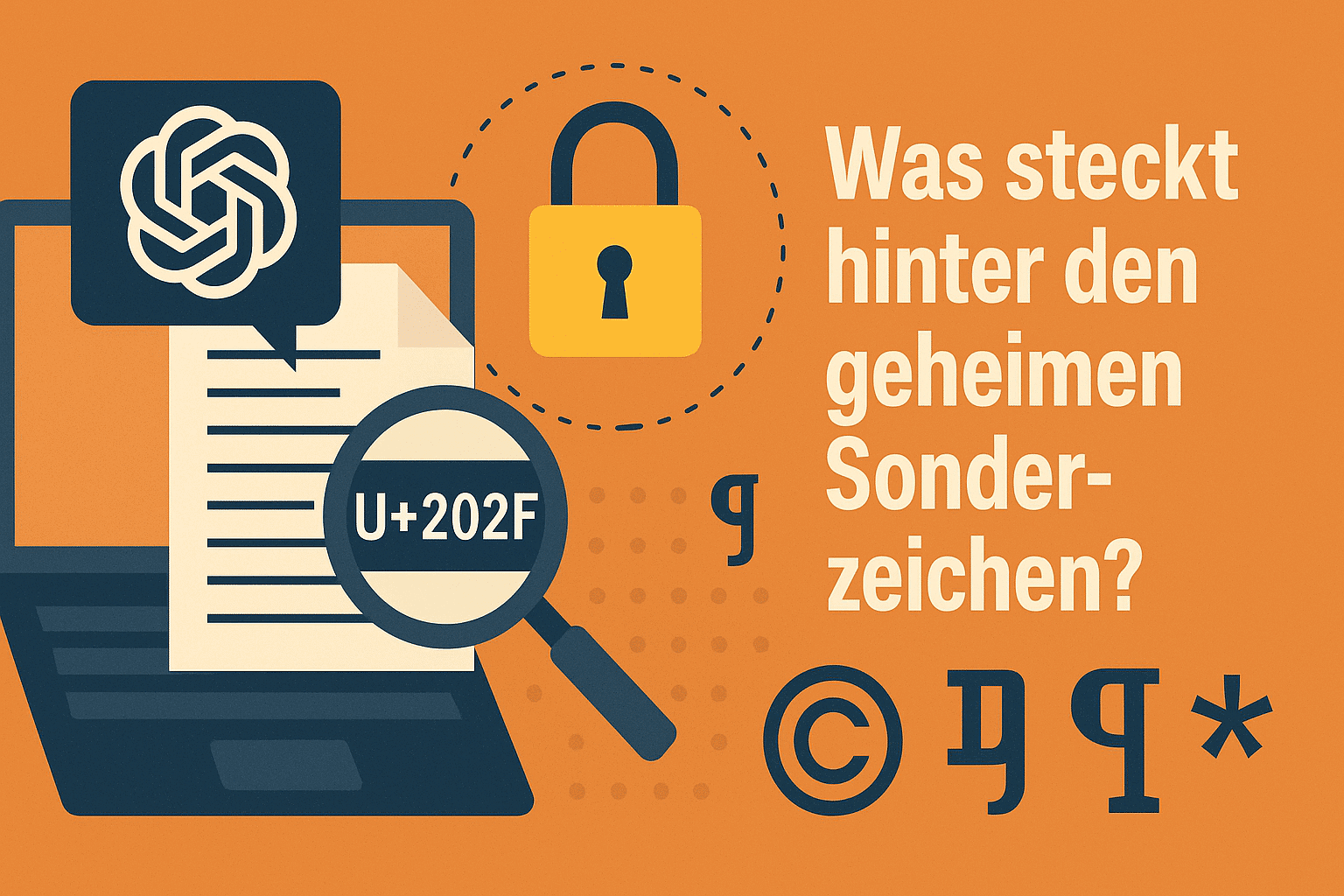

Im April 2025 machten Forscher des KI-Startups Rumi eine beunruhigende Entdeckung: Die neuen ChatGPT-Modelle GPT-o3 und GPT-o4-mini schienen unsichtbare Wasserzeichen in ihre Texte einzubetten. Diese „Signaturen“ bestanden aus speziellen Unicode-Zeichen wie dem „Narrow No-Break Space“ (U+202F), die für das menschliche Auge identisch zu normalen Leerzeichen aussehen, aber unterschiedliche digitale Codes besitzen.

Besonders brisant war der Zeitpunkt: OpenAI hatte gerade kostenlosen ChatGPT-Zugang für Studenten bis Ende Mai angekündigt – mitten in der Prüfungszeit. Die Vorstellung, dass Professoren plötzlich KI-generierte Texte durch versteckte Zeichen entlarven könnten, sorgte für Aufregung in der akademischen Welt.

Wie funktionieren die unsichtbaren Zeichen?

Die mysteriösen Zeichen erschienen hauptsächlich in längeren Texten, etwa wenn ChatGPT aufgefordert wurde, ganze Aufsätze zu schreiben. Während sie in normalen Textverarbeitungsprogrammen völlig unsichtbar blieben, konnten sie mit speziellen Tools entdeckt werden:

- Code-Editoren wie Sublime Text oder Visual Studio Code zeigen alle versteckten Zeichen an

- Online-Tools wie der SoSciSurvey Unicode Analyzer entlarven die Sonderzeichen

- Microsoft Word kann ebenfalls diese unsichtbaren Unicode-Marker erkennen

Das Perfide: Die Zeichen werden beim Kopieren und Einfügen automatisch mitübertragen. Wer also unbemerkt ChatGPT-Text verwendete, trug unwissentlich digitale Beweise seiner KI-Nutzung mit sich herum.

Absicht oder Versehen? Die Wahrheit überrascht

Zunächst vermuteten Experten eine bewusste Watermarking-Strategie von OpenAI. Schließlich hatte das Unternehmen bereits bei Bildern aus DALL-E experimentiert und sichtbare „ImageGen“-Labels eingeführt. Ein unsichtbares Textmarkierungssystem schien der logische nächste Schritt.

Doch OpenAI überraschte mit einer unerwarteten Erklärung: Die Sonderzeichen seien keine absichtlichen Wasserzeichen, sondern lediglich „eine Eigenart des großangelegten Reinforcement Learning“ – ein unbeabsichtigter Nebeneffekt des Trainingsprozesses.

Warum passiert so etwas?

Um zu verstehen, wie es zu diesem Phänomen kam, muss man die Funktionsweise moderner KI-Systeme betrachten. ChatGPT wird mit riesigen Textmengen aus dem Internet trainiert, darunter auch professionell formatierte Dokumente. Diese enthalten durchaus berechtigt spezielle Leerzeichen – etwa um zu verhindern, dass Währungssymbole und Beträge oder Initialen und Nachnamen durch Zeilenwechsel getrennt werden.

Die KI lernte diese typographischen Regeln und wendete sie nun übereifrig an – möglicherweise sogar akkurater als die meisten Menschen es täten. Was als technische Präzision gedacht war, wurde zum ungewollten Erkennungsmerkmal.

Experten vermuten außerdem, dass die spezielle Art des Reinforcement Learning bei den o-Serie-Modellen Probleme verstärkt, die normalerweise durch nachgelagerte Trainingsprozesse gemildert werden.

Das Katz-und-Maus-Spiel der KI-Erkennung

Der Fall zeigt exemplarisch die Herausforderungen bei der KI-Erkennung. Während die Tech-Industrie verzweifelt nach zuverlässigen Methoden sucht, um KI-Inhalte zu identifizieren, scheitern die meisten Ansätze an ihrer Umgehbarkeit:

- Google experimentiert mit SynthID für Bilder

- Microsoft bettet Metadaten in Azure-generierte Inhalte ein

- Meta setzt auf sichtbare Labels

Doch alle diese Methoden haben einen entscheidenden Schwachpunkt: Sie lassen sich relativ leicht umgehen. Die ChatGPT-Sonderzeichen waren da keine Ausnahme – eine simple Suchen-und-Ersetzen-Funktion reichte zur Entfernung.

Was können Nutzer tun?

Auch wenn OpenAI mittlerweile behauptet, das Problem behoben zu haben, ist Vorsicht geboten. Wer sichergehen möchte, dass seine Texte keine versteckten Zeichen enthalten, kann folgende Schritte unternehmen:

Sofortmaßnahmen:

- Text in einen einfachen Texteditor kopieren und neu formatieren

- Online-Tools zur Unicode-Analyse verwenden

- Paraphrasing-Tools einsetzen, die den Text umschreiben

Langfristige Strategegie:

- Transparenter Umgang mit KI-Unterstützung

- Bewusstsein für die Grenzen automatischer Erkennungssysteme entwickeln

- Fokus auf Verständnis statt auf Verschleierung

Fazit: Ein Weckruf für die KI-Ära

Der ChatGPT-Wasserzeichen-Skandal ist mehr als nur eine technische Kuriosität. Er zeigt, wie unvorhersehbar sich hochkomplexe KI-Systeme verhalten können und wie schnell unbeabsichtigte Funktionen entstehen, die weitreichende Konsequenzen haben.

Gleichzeitig verdeutlicht er das Dilemma der KI-Erkennung: Jede technische Lösung wird früher oder später geknackt. Statt auf immer ausgefeiltere Erkennungsmethoden zu setzen, sollten wir vielleicht ehrlichere Gespräche über den sinnvollen Einsatz von KI führen.

Denn eines ist sicher: In einer Welt, in der KI-Tools allgegenwärtig werden, ist Transparenz wichtiger als Tarnung. Die unsichtbaren Zeichen von ChatGPT haben uns daran erinnert – auch wenn das nicht beabsichtigt war.