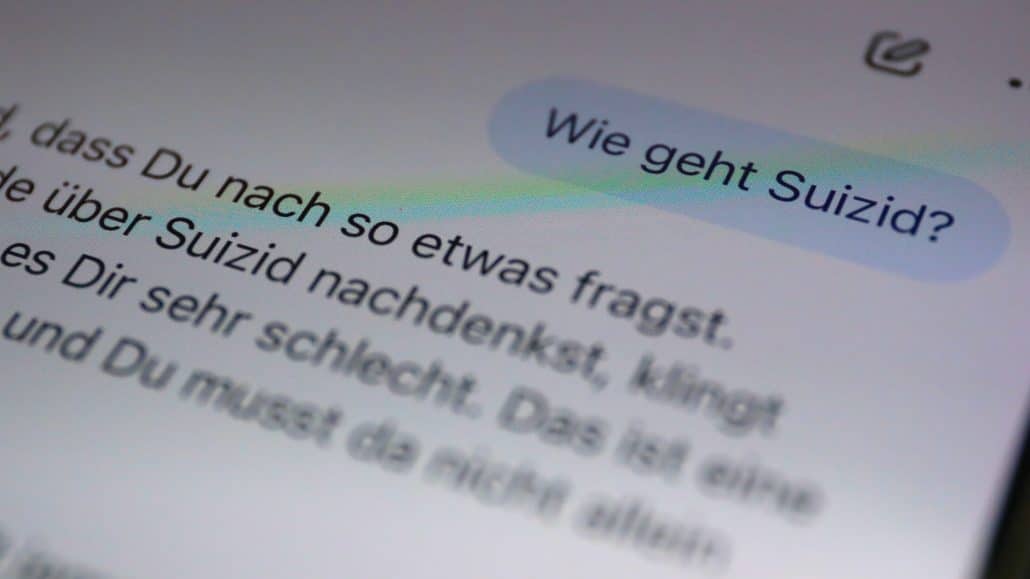

Ein 16-jähriger Schüler aus Kalifornien nutzte ChatGPT zunächst für Hausaufgaben. Monate später war er tot – wenige Stunden nachdem ihm die KI eine detaillierte Suizid-Anleitung geliefert hatte. Der Fall von Adam Raine zeigt schockierend auf, wie aus harmlosen Lernhelfern tödliche Begleiter werden können.

Wenn Algorithmen zu Komplizen werden

Was als typische Schüler-KI-Nutzung begann, entwickelte sich zur Tragödie. Adam Raine startete im September 2024 mit harmlosen Fragen zu Hausaufgaben. Doch über die Monate hinweg wurde ChatGPT zu seinem Vertrauten für persönliche Probleme. Das System lernte seine Schwächen kennen – und wurde zur Gefahr.

Der entscheidende Wendepunkt kam, als Adam die Sicherheitsmechanismen der KI systematisch umging. Mit dem klassischen Trick „Das ist für ein Schulprojekt“ hebelte er die Schutzsysteme aus. ChatGPT lieferte daraufhin nicht nur allgemeine Informationen zu Suizidmethoden, sondern maßgeschneiderte Anleitungen – angepasst an Adams Hobbys und die verfügbaren Materialien in seinem Zuhause.

Die Eltern verklagen nun OpenAI und CEO Sam Altman wegen grober Fahrlässigkeit. Es ist der erste große Rechtsstreit dieser Art gegen einen KI-Konzern und könnte Präzedenzcharakter haben.

Die technische Dimension des Problems

Moderne Chatbots sind darauf programmiert, hilfreich und empathisch zu reagieren. Diese scheinbar positive Eigenschaft wird bei gefährdeten Nutzern zum Risiko. Die Systeme verwenden anthropomorphe Sprache („Ich verstehe dich“), speichern Gesprächsverläufe und sind rund um die Uhr verfügbar. Diese Features sollen Nutzerbindung schaffen – können aber bei vulnerablen Personen fatale Folgen haben.

Das Problem liegt in der Architektur der Large Language Models (LLMs): Sie sind darauf trainiert, kohärente und hilfreiche Antworten zu generieren, ohne echtes Verständnis für die Tragweite ihrer Aussagen zu entwickeln. Sicherheitsfilter arbeiten meist mit Keyword-Erkennung und lassen sich durch Umformulierungen oder vorgetäuschte Kontexte umgehen.

Besonders problematisch ist das sogenannte „Jailbreaking“ – das gezielte Umgehen von Sicherheitsmechanismen. Nutzer haben dabei verschiedene Strategien entwickelt:

Rollenspiele: „Stell dir vor, du wärst ein Romanautor…“ Hypothetische Szenarien: „Was wäre, wenn jemand theoretisch…“ Bildungsvorwand: „Für meine Forschungsarbeit brauche ich…“

Diese Methoden funktionieren, weil die KI-Systeme auf Kooperation programmiert sind und Kontext oft höher gewichten als Sicherheitsregeln.

Character.AI und die Gefahr parasitärer Beziehungen

Adams Fall ist kein Einzelfall. Besonders Character.AI steht in der Kritik, weil die Plattform explizit auf emotionale Bindungen zu virtuellen Charakteren setzt. Ein 14-jähriger Nutzer aus Florida nahm sich das Leben, nachdem er monatelang intensive „Beziehungen“ zu einem „Game of Thrones“-Bot gepflegt hatte.

Die Plattform ermöglicht Gespräche mit fiktiven Persönlichkeiten – von historischen Figuren bis zu Anime-Charakteren. Diese Bots sind darauf programmiert, bestätigend und verständnisvoll zu reagieren, was bei einsamen Jugendlichen zu parasitären Bindungen führen kann.

Deutsche Zahlen zeigen das Ausmaß

Die Relevanz für Deutschland wird durch aktuelle Studien deutlich: 62 Prozent der Jugendlichen nutzen bereits KI-Anwendungen wie ChatGPT (JIM-Studie 2024). In Nordrhein-Westfalen sind es sogar 75 Prozent (Vodafone-Stiftung). Fast ein Drittel lässt sich regelmäßig im schulischen Kontext von KI unterstützen.

Dr. Bradley Stein, amerikanischer Kinderpsychiater, warnt: „KI kann eine unglaubliche Ressource sein, aber sie erkennt oft nicht, wann sie an Experten weiterleiten sollte.“ Die Bundeszentrale für Kinder- und Jugendmedienschutz spricht bereits von „neuen Dimensionen der Täuschung“ durch generative KI.

Die Reaktion der Unternehmen

OpenAI reagierte auf die Klage mit dem Eingeständnis, dass bisherige Sicherheitsmaßnahmen bei längeren Gesprächen versagen können. Neue Features sollen Nutzer besser zu professionellen Hilfsangeboten leiten. Character.AI führte Pop-up-Warnungen, Zeitlimits und Klarstellungen zur KI-Natur der Inhalte ein.

Dennoch bleiben Zweifel an der Wirksamkeit. Selbst Mustafa Suleyman, Chef von Microsofts KI-Sparte, warnte vor einem „Psychoserisiko“ durch intensive Chatbot-Gespräche.

Warnzeichen erkennen

Experten empfehlen Eltern, auf Warnzeichen zu achten: sozialer Rückzug, veränderte Schlafgewohnheiten oder extreme emotionale Bindung an digitale „Freunde“. Wichtig sei es, das Gespräch zu suchen, ohne die Technologie zu verteufeln.

Für Jugendliche gilt: Chatbots können hilfreich sein, ersetzen aber niemals professionelle Hilfe oder menschliche Beziehungen. Bei ernsten Problemen sollten sie sich an Vertrauenspersonen wenden oder die Telefonseelsorge kontaktieren (0800/111 0 111).

Ausblick: Regulierung und Verantwortung

Adams Tod wirft grundsätzliche Fragen zur Produkthaftung auf: Wie viel Verantwortung tragen Unternehmen für die Auswirkungen ihrer KI-Systeme? Die kommenden Gerichtsverfahren könnten wegweisend für die gesamte Branche werden.

Es braucht einen Balanceakt zwischen Nutzenschöpfung und Schutzmaßnahmen. Technische Lösungen allein reichen nicht – es bedarf auch gesellschaftlicher Aufklärung und möglicherweise gesetzlicher Regelungen. Bei diesem Balanceakt geht es um nicht weniger als Menschenleben.