Alle reden gerade über die gefälschten, erfundenen und manipulierten Geschichten, die im SPIEGEL erschienen sind. Dass sich Texte verfremden lassen, das kann sich jeder vorstellen. Aber Fotos, Audios und Videos? Doch, das geht auch. Sogar vergleichsweise einfach – und sehr effektiv. Wir brauchen geeignete Mittel, um uns gegen so etwas zu wehren.

Jeder kann mit einer App wie Mug Life Fotos bearbeiten. Mit wenigen Handgriffen und ein paar Mal Tippen lassen sich realistisch wirkende Bewegungen ins Gesicht zaubern, etwa das Hochziehen einer Augenbraue. Das Ergebnis: eine Bildmanipulation.

Nur wenige EUR teure Apps erlauben so etwas. Ein Lächeln hinzaubern, wo eigentlich gar kein Lächeln ist. Auch das geht. Mit dieser App hier kann man praktisch jeden Gesichtsmuskel beeinflussen – in jedem Foto!

Manipulationen für wenige EUR

Beeindruckend, oder? Aber auch ein bisschen spooky, finde ich.

Es gibt Dutzende solcher Apps, mit denen selbst Laien Fotos geschickt manipulieren – und aus Fotos bewegte Bilder machen können. Auf diese Weise entstehen Videos, die Dinge zeigen, die so nicht passiert sind.

So lange solche kleineren Manipulationen im Privatbereich oder schlichtweg als Gag zum Einsatz kommen, ist alles OK. Problematisch wird es, wenn woanders manipuliert wird. Wenn wir nicht mehr erkennen können, ob wir zum Beispiel einen echten Präsidenten sehen – oder einen manipulierten Clip. Hier ein Beispiel.

Dem Präsidenten alles in den Wort legen

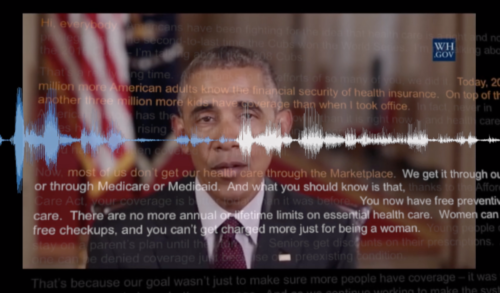

Wie bitte? Barack Obama sagt hier offiziell im Fernsehen: „President Trump is a total and complete dipshit“. Also: Präsident Trump ist ein Vollidiot. Das ist eigentlich nicht die Art von Obama, sieht doch aber täuschend echt aus, oder etwa nicht?

Doch das ist ein Fake. Ein so genannter Deep-Fake. Weil Inhalt, Bild und Ton gefälscht sind – und wir können es praktisch nicht erkennen. Denn wenn simple Apps fürs Smartphone schon beeindruckende Effekte hinbekommen, dann ist im Labor natürlich noch mehr möglich.

Entstanden ist das Obama-Video an der University of Washington. Grundlage ist ein Original-Video. Eine Ansprache von Obama. Danach hat sich Künstliche Intelligenz, KI, das Material angeschaut. Alles analysiert. Jedes Wort. Jede Gesichtsbewegung. Die Mimik. Es reichen einige Minuten Videomaterial. Danach kann die KI-Software den Menschen alles sagen lassen.

Ein Schauspieler spricht den Text. Das Video ist fertig. Oder aber, man legt einen komplett anderen Text unter das Video. Die KI-Software erzeugt dann das passende Video. Mit den typischen Bewegungen. Der üblichen Mimik. Das alles ist noch nicht unbedingt perfekt. Aber doch täuschend echt. Ausreichend, um im Netz oder auch im Fernsehen Millionen Menschen zu überzeugen.

Oder zu erschrecken. Zu manipulieren.

Künstliche Videos erzeugen und mit fremden Stimmen sprechen

Man kann also künstlich Videos erzeugen, die täuschend echt aussehen. Das will uns das University of Washington sagen. Sie will das nicht nutzen. Sie will uns warnen. Denn wenn die Uni das kann, dann können das Geheimdienste auch. Mühelos.

Was man wissen muss: Auch Stimmen lassen sich heute perfekt animieren.

Es gibt KI-Systeme, die lernen mit der Stimme einer jeden Person zu sprechen. Die KI-Software untersucht vorhandene Sprechtexte, 20 Minuten reichen. Schon spricht man jeden Text mit der Stimme jeder Person. Die perfekte Täuschung ist fertig.

Wir dürfen sicher sein, dass amerikanische, russische oder chinesische Geheimdienste so etwas können.

Quellen prüfen

Was bedeutet das? Das bedeutet, es wird immer wichtiger, die Quellen zu prüfen. Wir hier im Fernsehen machen das. Was im Internet kursiert, kann von überall kommen – und eben nicht nur Fake-News, sondern auch Deep-Fake sein.

Es wird immer schwieriger, wahr von falsch zu unterscheiden. Echt von unecht. Es wird bereits an Methoden entwickelt, die Fotoaufnahmen und Videos „versiegeln“. Methoden wie TruePic oder Serelay. Fotos und Videos bekommen eine Art Siegel, wenn sie gemacht werden. Jede Art von Veränderung oder Manipulation lässt sich so erkennen.

Fotos und Videos versiegeln

Funktioniert aber nur, wenn Fotos und Videos von Anfang an entsprechend behandelt und versiegelt werden. Eine offizielle Ansprache des Präsidenten oder der Bundeskanzlerin zum Beispiel könnte man so unterscheiden von einem Fake. Immerhin.

Es gibt also viele gute Gründe, skeptisch zu sein, wenn wir im Netz etwas sehen oder hören.