ChatGPT wird ständig weiter entwickelt. Seit der vierten Generation kann der Chatbot auch Bilder „verstehen“ – und darauf reagieren. Diese neue Funktion kann nun jeder testen.

Alle, die glauben zu wissen, was ChatGPT ist und kann, müssen jetzt ganz stark sein: Neben ChatGPT4 gibt es jetzt auch noch MiniGPT-4. MiniGPT-4 ist bitte nicht mit ChatGPT zu verwechseln: Dabei handelt es sich um ein Open-Source-Modell, das auf Wunsch detaillierte Beschreibungen über ein Bild erstellen kann, das vorher per Upload zur Verfügung gestellt wurde.

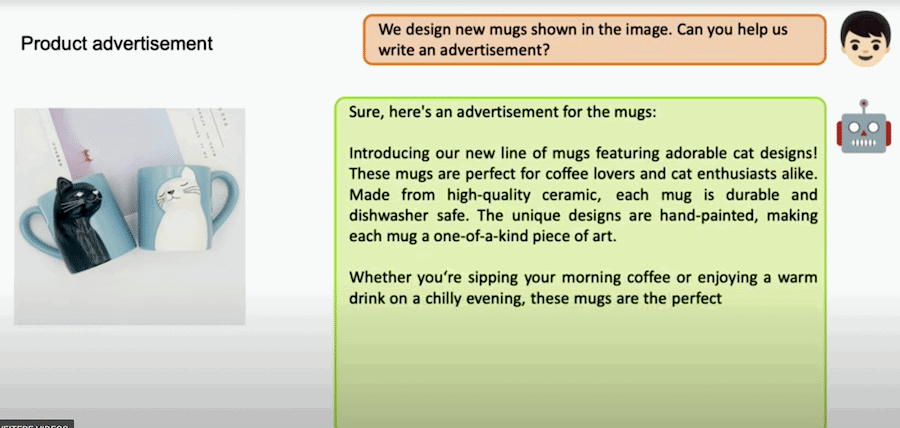

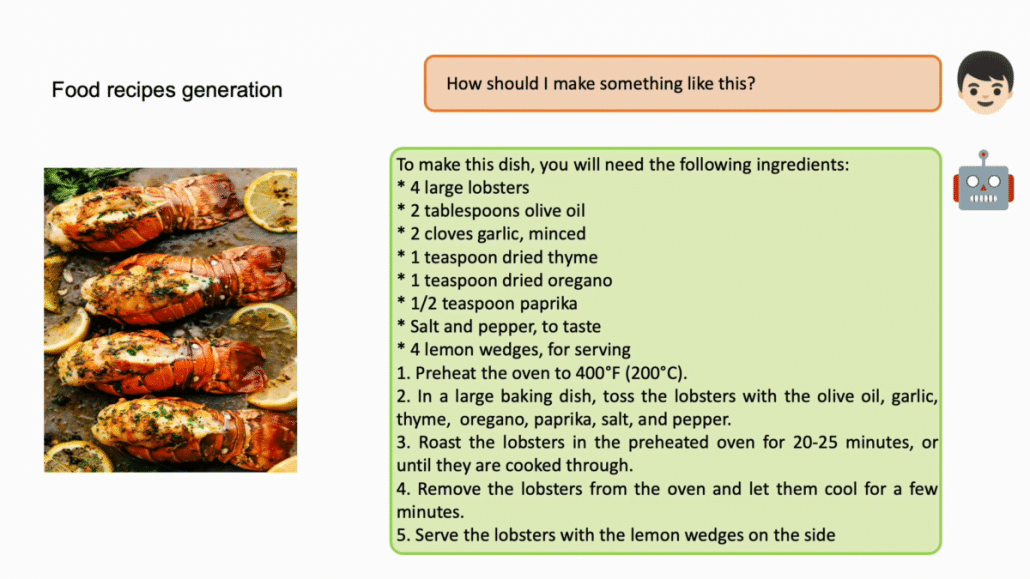

So, als würde man zu Kollege KI sagen: Du, schau mal – was siehst Du hier? Auf Wunsch erstellt der Chatbot Rezepte, basierend auf den Zutaten in einem Bild oder – und das wurde auf einer Präsentation gezeigt! – sogar Webseiten samt HTML-Code, allen aufgrund handgemalter Skizzen. Eigene Bilder generieren kann das System aber nach wie vor nicht.

Das Forscherteam von OpenAI hat den Code samt zahlreicher Demos sowie die Trainingsanleitung auf Github veröffentlicht und will auch eine Version des Modells anbieten. Es braucht aber ordentlich Rechen-Power: die Rede ist von einer Nvidia-3090-Grafikkarte.

Rezepte erstellen basierend auf den Zutaten in einem Bild

Texte, Bilder und Sprache

Ein Team von Forschern von OpenAI hat vor einiger Zeit die KI namens Multimodal MiniGPT-4 vorgestellt. Das Besondere an dieser Technologie ist, dass sie in der Lage ist, Texte, Bilder und Sprache in einer Art und Weise zu verarbeiten, wie es bisher nicht möglich war. Dadurch eröffnen sich neue Möglichkeiten für die Anwendung von künstlicher Intelligenz in verschiedenen Bereichen.

Die Idee hinter Multimodal MiniGPT-4 ist, die Vorteile von Text-basierten künstlichen Intelligenz-Modellen wie GPT-3 mit der Fähigkeit zur Bilderkennung und Sprachverarbeitung zu kombinieren. Dadurch soll die Technologie in der Lage sein, sowohl Texte als auch Bilder und Sprache zu verstehen und in einen Zusammenhang zu bringen. Das könnte zum Beispiel für die Entwicklung von Chatbots genutzt werden, die nicht nur auf geschriebene Texte, sondern auch auf Bilder und Sprache reagieren können.

ChatGPT: Was siehst Du in dem Bild?

Ein Beispiel für die Anwendung von Multimodal MiniGPT-4 ist die automatische Bildbeschreibung. Hierbei wird eine künstliche Intelligenz eingesetzt, um ein Bild zu beschreiben. Bislang waren solche Systeme darauf beschränkt, rein textbasierte Beschreibungen zu generieren. Mit Multimodal MiniGPT-4 wird die Technologie jedoch in der Lage sein, das Bild selbst zu erkennen und auf Basis dessen eine Beschreibung zu generieren, die nicht nur den Text, sondern auch das Bild selbst berücksichtigt.

Ein weiterer Anwendungsfall ist die Sprachverarbeitung. Hierbei könnte Multimodal MiniGPT-4 eingesetzt werden, um automatisch Untertitel für Videos zu generieren. Dabei würde die Technologie sowohl den gesprochenen Text als auch das Bild analysieren, um eine möglichst präzise und kontextabhängige Untertitelung zu erstellen.

Natürlich gibt es noch viele weitere Anwendungsgebiete für die Technologie, die derzeit von Forschern und Entwicklern erforscht werden. Einige davon könnten in der medizinischen Diagnostik eingesetzt werden, um zum Beispiel Röntgenbilder automatisch zu analysieren und eine Diagnose zu erstellen. Auch in der Robotik könnte die Technologie eingesetzt werden, um autonome Roboter zu entwickeln, die in der Lage sind, ihre Umgebung zu erkennen und darauf zu reagieren.

Was passiert, wenn jemand die Ballon loslässt?

Eine Herausforderung: Datenmengen

Die Möglichkeiten von Multimodal MiniGPT-4 sind also sehr vielfältig. Allerdings gibt es auch einige Herausforderungen, die es zu meistern gilt. Eine davon ist die Datenmenge, die benötigt wird, um die Technologie zu trainieren. Da Multimodal MiniGPT-4 sowohl Texte als auch Bilder und Sprache verarbeiten kann, benötigt sie entsprechend viele Daten in all diesen Bereichen, um eine möglichst hohe Genauigkeit zu erreichen.

Ein weiteres Problem ist die Komplexität der Technologie. Multimodal MiniGPT-4 besteht aus mehreren verschiedenen künstlichen Intelligenz-Modellen, die miteinander interagieren. Dadurch wird die Technologie sehr komplex, was die Entwicklung und Wartung erschwert.

Trotz dieser Herausforderungen ist Multimodal MiniGPT-4 ein vielversprechender Schritt in der Entwicklung von künstlicher Intelligenz. Die Möglichkeit, Text, Bilder und Sprache in einer Art und Weise zu verarbeiten, wie es bisher nicht möglich war, eröffnet neue Möglichkeiten für die Anwendung von künstlicher Intelligenz in verschiedenen Bereichen. Insbesondere die automatische Bildbeschreibung und die Sprachverarbeitung bieten große Potenziale für die Zukunft.

Risiken bedenken

Allerdings ist es auch wichtig, sich der möglichen negativen Auswirkungen von künstlicher Intelligenz bewusst zu sein. Es besteht die Gefahr, dass die Technologie dazu genutzt wird, um Menschen zu überwachen oder zu kontrollieren. Auch gibt es Bedenken hinsichtlich möglicher Diskriminierung durch künstliche Intelligenz-Systeme. Daher ist es wichtig, dass die Entwicklung von künstlicher Intelligenz in einer ethisch verantwortungsvollen Art und Weise erfolgt.

Insgesamt ist Multimodal MiniGPT-4 ein vielversprechender Schritt in der Entwicklung von künstlicher Intelligenz. Die Technologie eröffnet neue Möglichkeiten für die Anwendung von künstlicher Intelligenz in verschiedenen Bereichen und bietet großes Potenzial für die Zukunft. Allerdings müssen auch die Herausforderungen und möglichen negativen Auswirkungen von künstlicher Intelligenz im Auge behalten werden, um sicherzustellen, dass die Technologie in einer verantwortungsvollen Art und Weise eingesetzt wird.