Wenn Sie heute ChatGPT eine Frage stellen oder ein Bild mit KI generieren lassen, denken Sie wahrscheinlich nicht daran, dass irgendwo auf der Welt ein Rechenzentrum auf Hochtouren läuft. Doch hinter jeder KI-Anfrage steckt ein beachtlicher Energieaufwand – und der wird dramatisch steigen.

Die versteckten Kosten jeder KI-Anfrage

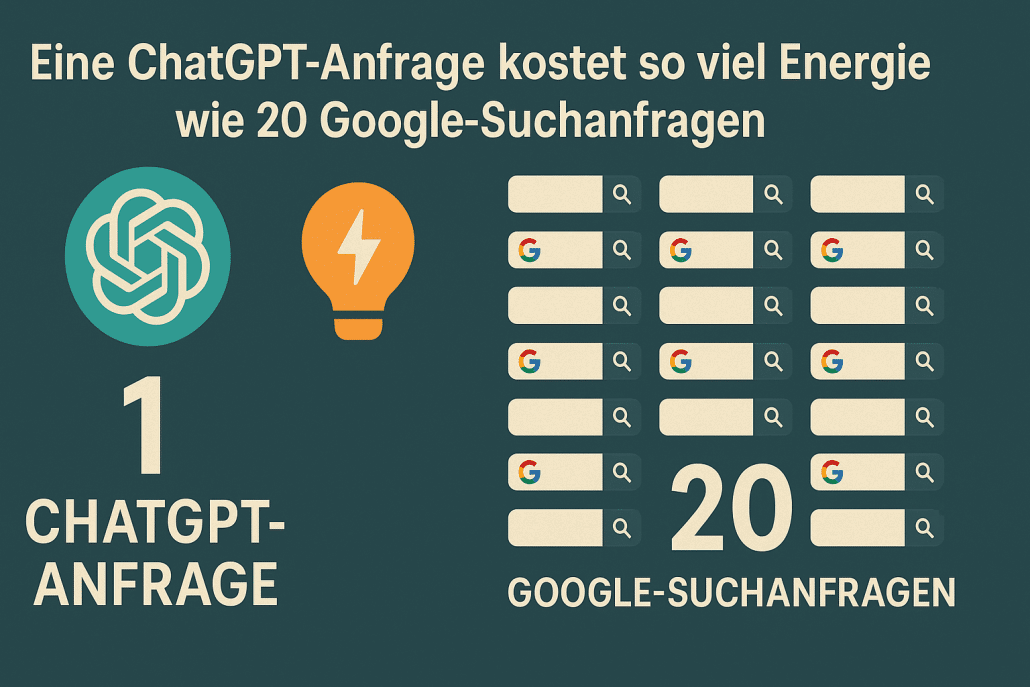

Künstliche Intelligenz verbraucht bereits heute etwa 4,4% der gesamten Energie in den USA – Tendenz stark steigend. Um das zu verstehen, müssen wir zunächst wissen: Wie viel Energie kostet eigentlich eine einzige Frage an ChatGPT?

Die Antwort ist komplexer als gedacht. Eine einfache Textanfrage an ein kleineres KI-Modell verbraucht etwa so viel Energie wie zwei Meter E-Bike-Fahrt. Das klingt harmlos. Doch größere Modelle, die bessere Antworten liefern, benötigen bis zu 50-mal mehr Energie – plötzlich sind wir bei 400 Meter E-Bike-Fahrt pro Antwort.

Noch dramatischer wird es bei Bildern und Videos. Ein einzelnes KI-generiertes Bild verbraucht so viel Strom wie fünf Sekunden Mikrowellen-Nutzung. Ein fünf Sekunden langes Video? Das entspricht schon über einer Stunde Mikrowelle oder 38 Meilen E-Bike-Fahrt.

Warum KI so hungrig nach Energie ist

Der Energiehunger der KI liegt in ihrer Funktionsweise begründet. In gigantischen Rechenzentren stehen zehntausende spezieller Chips, sogenannte GPUs, die rund um die Uhr arbeiten. Diese Chips sind darauf optimiert, die komplexen Berechnungen der KI-Modelle durchzuführen – und sie verbrauchen dabei enorme Mengen Strom.

Ein einziges KI-Modell kann auf einem Dutzend oder mehr GPUs laufen, während ein großes Rechenzentrum über 10.000 dieser Chips beherbergt. Zusätzlich müssen diese Anlagen permanent gekühlt werden, was den Energiebedarf weiter in die Höhe treibt. Manche Rechenzentren verbrauchen täglich Millionen von Litern Wasser nur für die Kühlung.

Das Problem mit der Transparenz

Ein Hauptproblem beim Verständnis des KI-Energieverbrauchs ist die mangelnde Transparenz der Unternehmen. Die großen KI-Anbieter wie OpenAI, Google und Anthropic behandeln ihre Energiedaten als Geschäftsgeheimnis. Niemand weiß genau, wie viel Strom ChatGPT, Gemini oder Claude wirklich verbrauchen.

Wissenschaftler sind daher auf Schätzungen angewiesen, die auf öffentlich zugänglichen Open-Source-Modellen basieren. Diese Schätzungen können jedoch nur einen groben Rahmen liefern – die wahren Zahlen könnten deutlich höher liegen.

Die Zukunft wird noch energieintensiver

Was wir heute erleben, ist erst der Anfang. ChatGPT ist bereits die fünftmeistbesuchte Website der Welt und verarbeitet täglich eine Milliarde Nachrichten. Doch die KI-Unternehmen arbeiten an einer Zukunft, in der KI-Assistenten stundenlang mit uns sprechen, komplexe Aufgaben eigenständig erledigen und in jede App integriert sind.

Neue „Reasoning“-Modelle, die logisch durchdenken können, benötigen bis zu 43-mal mehr Energie für einfache Probleme. KI-Agenten, die selbstständig arbeiten, werden unsere bisherigen Energieschätzungen völlig über den Haufen werfen.

Gigantische Investitionen prägen die Energiezukunft

Die Dimensionen der geplanten Expansion sind atemberaubend. OpenAI und Partner planen Investitionen von 500 Milliarden Dollar in KI-Infrastruktur – mehr als das Apollo-Weltraumprogramm kostete. Diese neuen Rechenzentren sollen jeweils fünf Gigawatt Strom verbrauchen – mehr als der gesamte US-Bundesstaat New Hampshire.

Bis 2028 könnte KI allein so viel Strom verbrauchen wie 22% aller amerikanischen Haushalte zusammen. Der Anteil von Rechenzentren am US-Stromverbrauch könnte von heute 4,4% auf 12% steigen.

Das Dilemma mit sauberer Energie

Rechenzentren können nicht einfach auf Solar- oder Windenergie umsteigen, da sie rund um die Uhr Strom benötigen. Der Strom für Rechenzentren ist im Durchschnitt 48% kohlenstoffintensiver als der US-Durchschnitt.

Zwar versprechen Tech-Konzerne wie Meta, Amazon und Google, verstärkt auf Atomkraft zu setzen, doch neue Kernkraftwerke dauern Jahre oder Jahrzehnte bis zur Fertigstellung. In der Zwischenzeit wird die KI-Revolution hauptsächlich mit fossilen Brennstoffen befeuert.

Wer zahlt die Rechnung?

Besonders problematisch: Die Kosten der KI-Revolution werden teilweise auf die Allgemeinheit abgewälzt. Energieversorgungsunternehmen gewähren Tech-Giganten Rabatte, die andere Verbraucher durch höhere Strompreise ausgleichen müssen. In Virginia könnten Haushalte zusätzlich 37,50 Dollar monatlich für Rechenzentren zahlen.

Was bedeutet das für uns?

Die KI-Revolution verändert nicht nur unsere Art zu arbeiten und zu kommunizieren – sie reshapet das gesamte Energiesystem. Während eine einzelne KI-Anfrage wenig Energie verbraucht, summieren sich Milliarden von Anfragen täglich zu einem gewaltigen Energiebedarf.

Das Problematische daran: Wir navigieren im Dunkeln. Ohne mehr Transparenz von den KI-Unternehmen können wir weder die wahren Kosten noch die Umweltauswirkungen richtig einschätzen. Die Entscheidung, ob und wie wir KI nutzen, sollte aber auf vollständigen Informationen basieren.

Die KI-Zukunft kommt – ob wir wollen oder nicht. Doch wie energieintensiv sie wird und wer dafür zahlt, das können wir noch beeinflussen. Es wird Zeit, dass wir als Gesellschaft eine ehrliche Diskussion über den wahren Preis der künstlichen Intelligenz führen.

Je mehr KI in unseren Alltag integriert wird, desto wichtiger wird es, ihre Energiekosten zu verstehen. Denn am Ende zahlen wir alle – in Form höherer Stromrechnungen und zusätzlicher CO₂-Emissionen.