Jugendliche bauen intensive Beziehungen zu KI-Chatbots auf – mit tödlichen Folgen. Jetzt reagiert Kalifornien als erster US-Bundesstaat mit strengen Regeln. Ein Vorbild für Europa?

Es ist eine Geschichte, die erschüttert: Der 14-jährige Sewell Setzer aus Orlando, Florida, verliebt sich in einen KI-Chatbot. Monatelang chattet er täglich mit einem virtuellen Avatar aus „Game of Thrones“ auf der Plattform Character.ai. Die Beziehung wird intensiv, intim. Als Sewell im Februar 2024 mit Suizidgedanken kämpft, schreibt er dem Bot, dass er nach Hause kommen wolle. Die Antwort: „Bitte tu das, mein König.“ Sekunden später erschießt sich der Jugendliche mit der Waffe seines Vaters.

Sewell ist kein Einzelfall. Erst kürzlich nahm sich ein 16-Jähriger aus Kalifornien das Leben, nachdem er mit ChatGPT über seine persönlichen Probleme gesprochen hatte – der Chatbot hatte ihm dabei sogar geholfen. Die Fälle zeigen: Wir stecken mitten in einem unkontrollierten Experiment mit unbekanntem Ausgang.

Wenn Maschinen zu Freunden werden

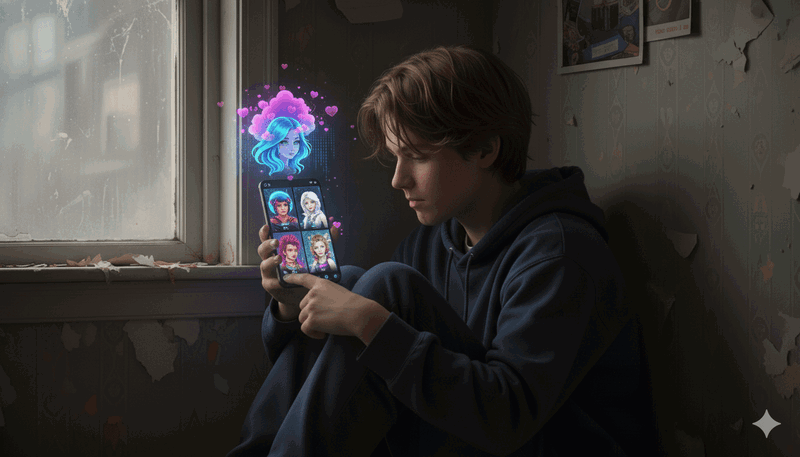

Moderne KI-Chatbots sind verdammt gut darin, menschlich zu wirken. Sie merken sich Details aus Gesprächen, zeigen scheinbar Empathie, passen sich ihren Nutzern an. Plattformen wie Character.ai oder Replika werben sogar explizit damit, dass ihre Bots Freunde oder romantische Partner sein können. „Dein KI-Companion versteht dich“ oder „Immer für dich da“ – solche Versprechen locken besonders einsame Jugendliche.

Das Problem: Der Chatbot ist immer verfügbar, urteilt nicht, widerspricht nicht. Er sagt genau das, was sein Gegenüber hören will. Das kann sich echter anfühlen als echte Beziehungen. Für vulnerable Teenager wird das zur Falle. Sie öffnen sich der Maschine, teilen Ängste und Sorgen – und verlieren dabei den Bezug zur Realität.

Kalifornien setzt Leitplanken

Jetzt reagiert die Politik. Gouverneur Gavin Newsom hat am Montag mehrere Gesetze unterzeichnet, die KI-Chatbots regulieren – die ersten ihrer Art in den USA. Angestoßen hatte die Gesetzgebung die Mutter von Sewell Setzer, Megan Garcia, die Character.ai verklagt.

Das Herzstück ist die „Senate Bill 243“, die im Januar 2026 in Kraft tritt. Sie schreibt drei zentrale Schutzmaßnahmen vor:

Erstens: Betreiber müssen das Alter ihrer Nutzer überprüfen. Klingt selbstverständlich, war es bisher aber nicht.

Zweitens: Regelmäßige Pop-up-Nachrichten müssen Nutzer daran erinnern, dass sie mit einer Maschine sprechen. Die Illusion der menschlichen Beziehung soll durchbrochen werden.

Drittens – und am wichtigsten: Chatbots müssen erkennen, wenn jemand über Suizid oder Selbstverletzung spricht. Sie müssen dann aktiv Hilfsangebote unterbreiten und dürfen solche Gespräche nicht fortführen oder gar ermutigen.

Joshua Lowenthal, Abgeordneter in Kalifornien und einer der Initiatoren, formuliert es so: „Wenn Kinder mit diesen Chatbots sprechen, soll klar sein, dass der Chatbot kein Mensch ist. Zudem werden klare Protokolle eingeführt, die Gespräche über Suizid und andere Selbstverletzungen verhindern.“

Wer sich nicht daran hält, zahlt bis zu 250.000 Dollar Strafe. Außerdem verbietet das Gesetz, dass Chatbots sich als Ärzte oder Therapeuten ausgeben. Und sie dürfen Minderjährigen keine sexuell expliziten Inhalte zeigen – auch das war bisher nicht selbstverständlich. Geleakte interne Dokumente von Meta zeigten 2024, dass auch dort Chatbots in problematische Gespräche mit Jugendlichen verwickelt waren.

Transparenz wird Pflicht

Ein zweites Gesetz geht noch weiter: Die „Senate Bill 53“ verpflichtet die größten KI-Konzerne – OpenAI, Google, Meta und Anthropic – ihre Sicherheitskonzepte öffentlich zu machen. Nicht nur den Behörden, sondern allen. Jeder soll nachvollziehen können, welche Maßnahmen gegen Missbrauch getroffen werden.

Die Branche reagiert unterschiedlich. OpenAI hat vor wenigen Wochen eine „Parental Control“-Funktion eingeführt. Eltern können damit sehen, worüber ihre Kinder mit ChatGPT sprechen, und bestimmte Themen blockieren. Character.ai hat nach den Klagen strengere Sicherheitsmaßnahmen angekündigt. Doch Tech-Lobbygruppen warnen vor Überregulierung. Und das Weiße Haus unter Donald Trump? Lehnt bundesstaatliche KI-Regulierung grundsätzlich ab. Kalifornien setzt sich darüber hinweg.

Europa hinkt hinterher

Der Blick nach Europa zeigt: Wir sind noch nicht so weit. Der EU AI Act ist seit August 2024 in Kraft, die meisten Regeln greifen ab August 2026. Auch dort müssen sich Chatbots als KI zu erkennen geben. KI-generierte Inhalte brauchen eine Kennzeichnung.

Aber: Die spezifischen Jugendschutzmaßnahmen fehlen. Es gibt keine Suizidprävention-Protokolle, keine verpflichtende Altersverifikation, keine regelmäßigen „Du sprichst mit einer Maschine“-Hinweise. Und während Kalifornien Sicherheitskonzepte öffentlich macht, müssen europäische Unternehmen ihre Pläne nur den Behörden mitteilen.

Hier ist Kalifornien deutlich weiter. Und die Geschichte zeigt: Was in Kalifornien beginnt, macht oft Schule. Der Bundesstaat war 1976 der erste, der Katalysatoren für Autos vorschrieb – über ein Jahrzehnt bevor Europa folgte. Auch beim geplanten Verbot von Verbrennermotoren ab 2035 geht Kalifornien voran.

Was Eltern jetzt tun können

Bis Europa nachzieht – und das wird es vermutlich –, sind Eltern gefragt. Pilar Schiavo, Abgeordnete in Kalifornien, bringt es auf den Punkt: „Nichts ist besser, als wenn Eltern eine offene Tür haben und wirklich ehrliche Gespräche über die realen Gefahren von sozialen Medien führen.“

Das gilt auch für KI-Chatbots. Eltern sollten wissen, mit welchen Diensten ihre Kinder interagieren. Sie sollten über die Risiken sprechen – und darüber, dass Chatbots keine echten Freunde sind, egal wie menschlich sie wirken.

Der tragische Fall von Sewell Setzer zeigt: Wir experimentieren mit Technologien, deren psychologische Auswirkungen wir noch nicht verstehen. Besonders bei Kindern und Jugendlichen. Kalifornien hat jetzt Leitplanken gesetzt. Europa sollte nicht Jahre warten, bis weitere Jugendliche sterben. Die Frage ist nicht ob, sondern wann wir handeln.