KI-generierte Inhalte sind längst Alltag auf Social Media – und oft kaum noch von echten zu unterscheiden. Nach dem EU AI Act haben die großen Plattformen ihre Kennzeichnungssysteme massiv ausgebaut. Wie gut funktioniert die Transparenz bei Meta, TikTok & Co?

Die Frage stellt sich heute permanent: Echt – oder mit KI gemacht?

Zwei Jahre nach den ersten Ankündigungen ist KI-Kennzeichnung auf Social Media Realität geworden. Was 2024 als freiwilliges Pilotprojekt startete, ist seit dem EU AI Act von 2025 zur Pflicht geworden. Und das war auch dringend nötig: Moderne KI-Systeme wie Midjourney V6, Stable Diffusion 3.0 oder DALL-E 4 produzieren heute Bilder, die selbst Experten oft nicht mehr von echten Fotos unterscheiden können.

Das Problem ist real geworden

Was früher Zukunftsmusik war, ist heute bittere Realität: KI-generierte Fake-Fotos überfluten das Netz. Besonders problematisch wird es bei politischen Events, Naturkatastrophen oder anderen gesellschaftlich relevanten Themen. Da visuelle Inhalte enormen Einfluss auf die Meinungsbildung haben, können täuschend echte KI-Fotos die Glaubwürdigkeit von Informationen komplett untergraben.

Manipulierte Bilder werden systematisch eingesetzt, um falsche Ereignisse zu inszenieren, Personen zu diffamieren oder politische Propaganda zu verbreiten. Die Grenzen zwischen Realität und KI-Fiction sind praktisch verschwunden. Ohne verlässliche Erkennungssysteme droht ein kompletter Vertrauensverlust in visuelle Medien.

Auf Facebook, Instagram, X (ehemals Twitter), YouTube und TikTok posten User täglich Millionen KI-generierter Inhalte. Oft ist nicht erkennbar, wer oder was die Inhalte erstellt hat. Der Grund ist simpel: KI-Tools sind heute so zugänglich und mächtig geworden, dass praktisch jeder fotorealistische Inhalte auf Knopfdruck erzeugen kann.

KI-Revolution: Von erkennbar zu perfekt

Die Entwicklung ist atemberaubend: Während KI-Bilder vor zwei Jahren noch durch merkwürdige Hände oder unrealistische Details auffielen, sind heutige Generationen wie Midjourney V7, Flux Pro oder Adobe Firefly 3 praktisch nicht mehr zu entlarven. Sogar Videos lassen sich mittlerweile mit Tools wie Sora 2.0, RunwayML Gen-3 oder Pika 2.0 täuschend echt generieren.

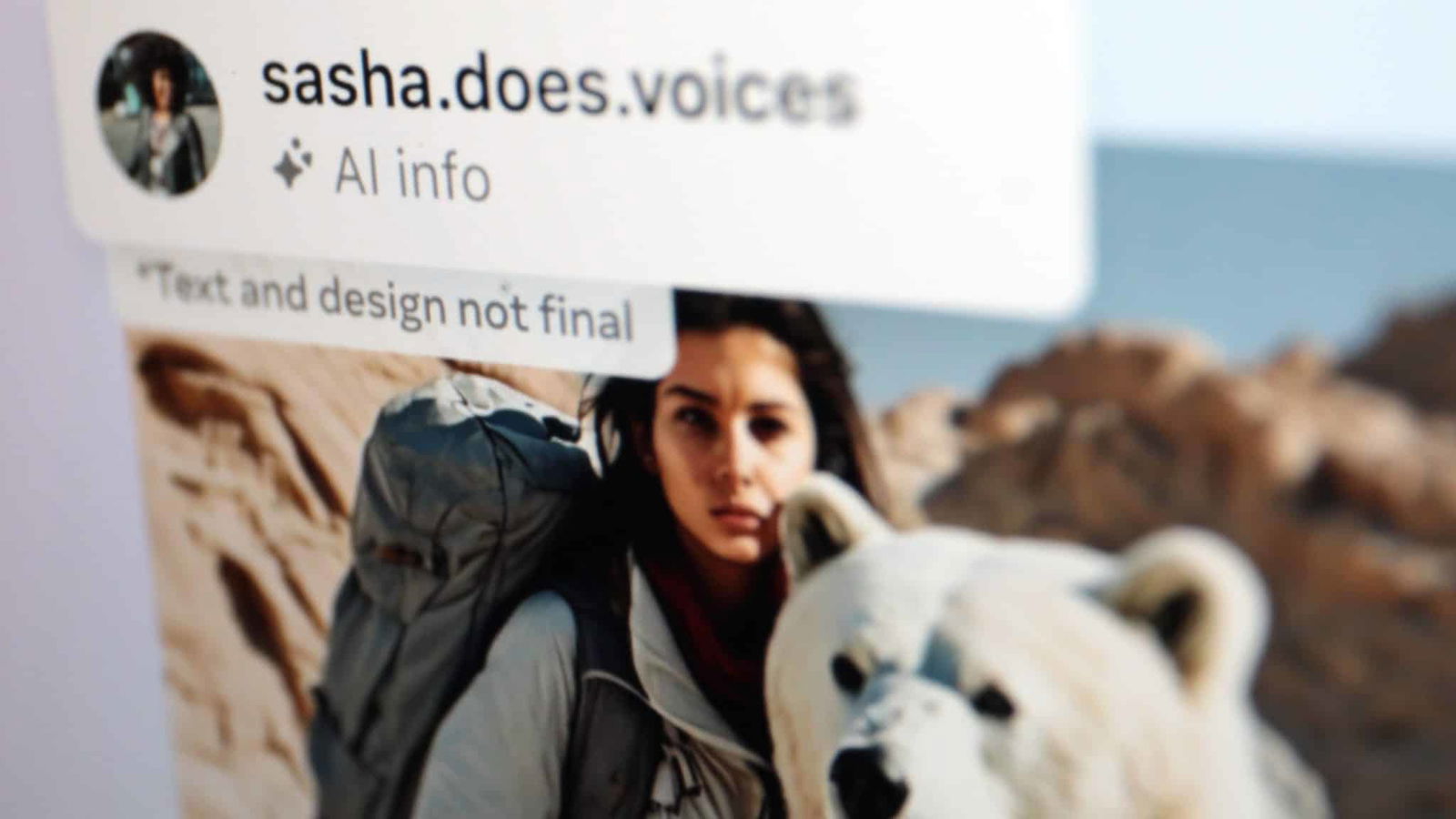

Deshalb haben die großen Plattformen seit 2025 ihre Kennzeichnungssysteme massiv ausgebaut. Meta war Vorreiter und markiert seit Mai 2024 KI-Inhalte automatisch. Heute erkennen die Systeme nicht nur Bilder, sondern auch Audio- und Videoinhalte mit hoher Trefferquote.

„Transparenz ist der Schlüssel zum Vertrauen in KI-Technologie“, erklärt Nick Clegg, Metas Chief Global Affairs Officer. Das Prinzip: Nicht blocken oder löschen, sondern markieren und Kontext liefern. User sollen selbst entscheiden können, welche Inhalte sie konsumieren möchten.

So funktioniert die automatische Erkennung

Die Erkennungstechnologie hat sich seit 2024 dramatisch verbessert. Metas KI-Detektoren analysieren heute nicht nur Metadaten und Wasserzeichen, sondern untersuchen auch Pixel-Anomalien, Kompressionsartefakte und statistische Bildmuster. Dabei kommen mehrere Standards zum Einsatz.

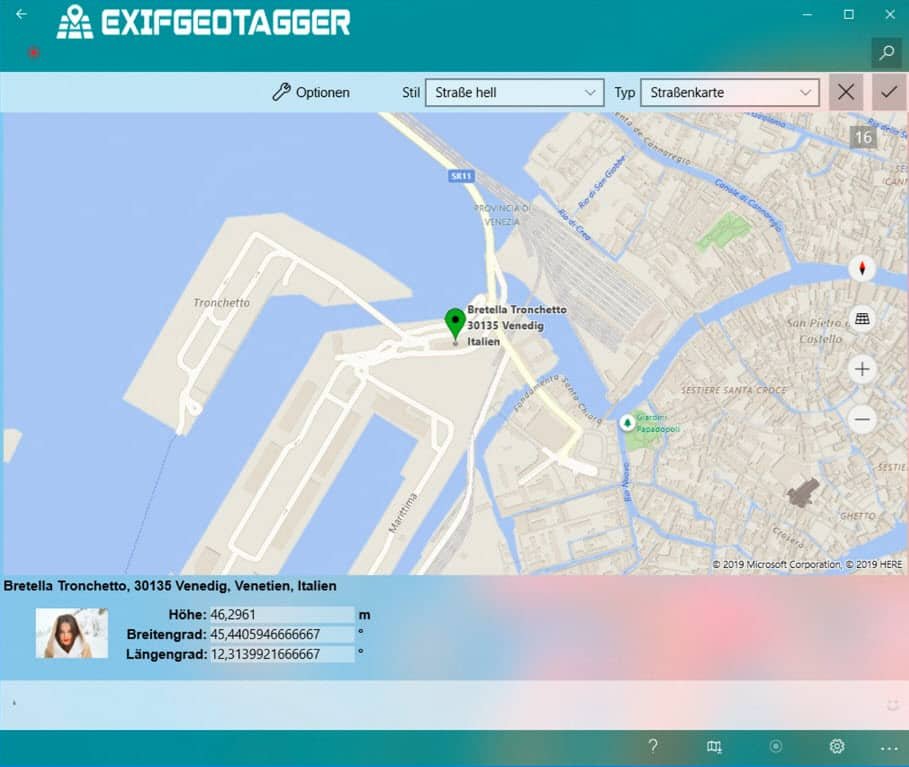

Praktisch alle großen KI-Bildgeneratoren – von OpenAI über Stability AI bis zu Google – implementieren heute den C2PA-Standard (Coalition for Content Provenance and Authenticity). Dieser fügt unsichtbare kryptographische Signaturen in Bilder ein, die deren Herkunft dokumentieren. Zusätzlich werden IPTC-Metadaten genutzt, die standardisierte Informationen über die Bildgenerierung enthalten.

Katz-und-Maus-Spiel um Wasserzeichen

Trotz technischer Fortschritte bleibt die KI-Erkennung ein ständiges Katz-und-Maus-Spiel. Erfahrene User können Wasserzeichen mit Tools wie „Watermark Remover AI“ oder durch geschickte Bildbearbeitung entfernen. Auch das simple Re-Fotografieren eines Bildschirms kann Erkennungsalgorithmen austricksen.

Deshalb setzen die Plattformen heute auf hybride Ansätze: Neben der technischen Erkennung analysieren fortgeschrittene KI-Systeme auch den Kontext von Posts, das Nutzerverhalten und weitere Signale. Meta, Google und Microsoft investieren Milliarden in die Entwicklung robusterer Erkennungstechnologien.

Besonders herausfordernd sind „Style Transfer“-Techniken, bei denen echte Fotos mit KI-Filtern bearbeitet werden, oder „Inpainting“, wo nur Teile eines Bildes KI-generiert sind. Hier verschwimmen die Grenzen zwischen Bearbeitung und kompletter Neuerstellung.

EU AI Act macht Kennzeichnung zur Pflicht

Seit August 2025 ist der EU AI Act vollständig in Kraft und macht KI-Kennzeichnung zur rechtlichen Verpflichtung. Plattformen müssen „deepfakes“ und andere täuschende KI-Inhalte verpflichtend markieren – bei Verstößen drohen Strafen von bis zu 7% des weltweiten Jahresumsatzes.

Die Regelung geht weit über Bilder hinaus: Auch KI-generierte Videos, Audio-Clips und sogar Texte müssen gekennzeichnet werden, wenn sie zur Täuschung geeignet sind. TikTok führte deshalb im Herbst 2025 ein umfassendes Labeling-System ein, YouTube folgte im Winter.

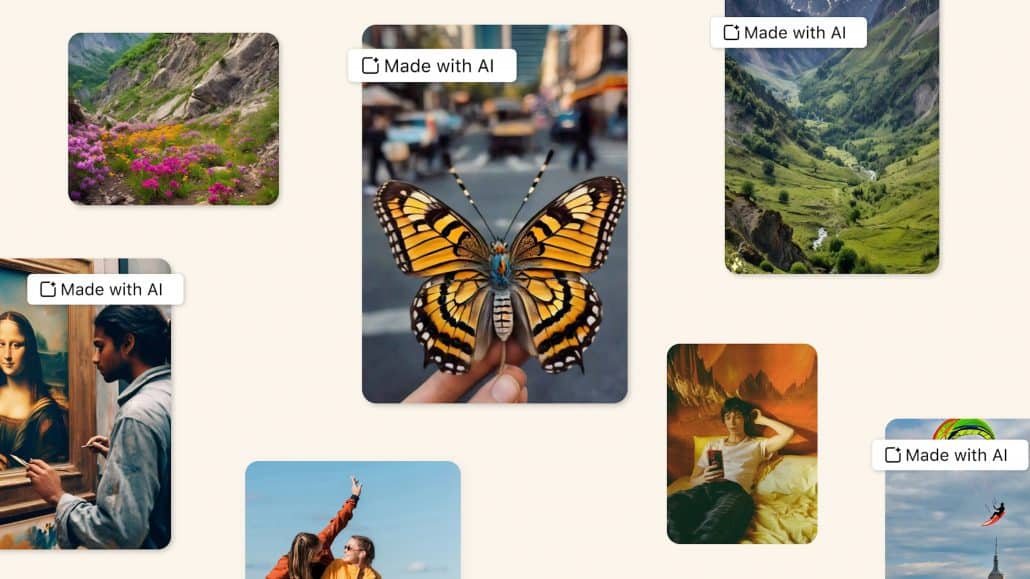

Parallel entwickeln sich auch positive Anwendungen: Creator nutzen KI-Labels bewusst als Qualitätsmerkmal und zeigen damit ihre Expertise im Umgang mit neuen Technologien. „Made with AI“ wird vom Stigma zum Gütesiegel für innovative Inhalte.

Ausblick: Die Zukunft der Content-Authentizität

2026 arbeiten alle großen Tech-Konzerne an der nächsten Generation von Authentizitäts-Tools. Adobe entwickelt mit „Content Credentials“ ein blockchainbasiertes System, das die komplette Entstehungsgeschichte von Inhalten dokumentiert. OpenAI testet bereits „Neural Watermarks“, die auch bei extremer Kompression erhalten bleiben.

Gleichzeitig entstehen neue Herausforderungen: Live-KI-Filter in Videokonferenzen, Real-time-Deepfakes oder KI-gesteuerte Avatare machen die Grenzen zwischen echt und künstlich noch unschärfer. Die Antwort liegt nicht nur in besserer Technik, sondern auch in Digital Literacy – der Fähigkeit von Usern, kritisch mit Inhalten umzugehen.

Zuletzt aktualisiert am 17.02.2026